Vos données valent-elles de l’or ?

Avant-propos

Pour innover et survivre, les entreprises industrielles doivent constamment adopter de nouvelles techniques, de nouvelles compétences, de nouvelles configurations de travail. Au confluent de ces trois novations, les technologies numériques et plus particulièrement l’internet des objets (IoT) leur ouvrent des perspectives prometteuses. Parce qu’il fait dialoguer entre elles des machines-outils qui n’étaient pas originellement conçues pour cela, parce qu’il permet d’élaborer le jumeau numérique d’un atelier ou d’une supply chain pour en optimiser le fonctionnement, ou encore parce qu’il permet de « garder le contact » avec les objets vendus une fois ceux-ci en fonctionnement (qu’il s’agisse d’ascenseurs, de poids-lourds ou de brosses à dents), l’IoT met au service de la fabrication industrielle la fluidité du réseau et la puissance de l’intelligence artificielle.

De cette prémisse, certains en déduisent que la donnée serait devenue une nouvelle matière première : en passant de l’optimisation à la génération volontaire de data, l’industrie accéderait à de nouvelles sources de valeur, comme l’ont indubitablement réussi Google et Facebook, et donc à de nouveaux modèles d’affaires. Le rêve d’un nouvel eldorado est d’autant plus palpable que quiconque aujourd’hui peut ériger des montagnes de données pour une bouchée de pain. Mais d’autres experts du métier, sceptiques, ne manquent pas de rappeler que la ruée vers l’or n’a jamais enrichi que les vendeurs de pioches et qu’il vaudrait mieux pour les entreprises continuer à fabriquer aussi bien que possible ce qu’elles savent déjà vendre…

La vérité se niche bien entendu à saine distance des récits excessifs. Savoir si l’IoT constitue plutôt une évolution industrielle radicale à diffusion rapide ou une opportunité de niche réservée à quelques chanceux réclame de s’adresser aux experts et, surtout, d’aller enquêter sur le terrain. C’est le propos de cet ouvrage, volontairement factuel et accessible, qui traite de la mise en œuvre des projets d’IoT industriel, de leurs promesses et de leurs limites. On y verra notamment l’importance déterminante, pour répondre aux questions précédentes, des modalités choisies pour la gestion des projets en question et, plus encore, de leur articulation avec les autres transformations de « l’art de faire » dans l’industrie, à commencer par le lean manufacturing.

La collection des « Docs de La Fabrique » rassemble des textes qui n’ont pas été élaborés à la demande ni sous le contrôle de son conseil d’orientation, mais qui apportent des éléments de réflexion stimulants pour le débat et la prospective sur les enjeux de l’industrie. Nous ne doutons pas que ce document offrira aux industriels et aux salariés des pistes de réflexion sur les axes de transformation des entreprises.

L’équipe de La Fabrique

Préface

Oseriez-vous confier à un inconnu croisé dans la rue vos nom, adresse, e-mail, mais aussi vos date/lieu de naissance sans oublier votre numéro de carte de crédit et son précieux cryptogramme… ? Certainement pas !

Alors réfléchissez-y maintenant à deux fois lorsque vous commanderez en ligne votre article préféré auprès de l’entreprise qui gardera pour toujours ces informations dans son coffre-fort numérique : son Data Center !

D’après vous, ces entreprises sont-elles respectueuses des échanges qu’elles effectuent avec vos données confidentielles et sont-elles toutes en mesure de les exploiter ou de les protéger correctement ?

Dans cet ouvrage didactique, très « terrain », vous trouverez de nombreux exemples concrets, des analyses mais aussi des pistes de réflexion quant à la propriété mais aussi et surtout la juste valeur de vos fameuses données.

Je travaille depuis plus de trente ans dans le monde des data, de la sécurité de l’information, en France comme à l’international, et je peux témoigner que le wake-up call – sur les avantages concurrentiels que procure la donnée, ainsi que l’importance d’en maîtriser la sécurité – a été aussi soudain que violent.

La première secousse de magnitude 9+ a été déclenchée par les Américains.

En effet, pour mettre fin à une bataille judiciaire opposant Microsoft à l’administration américaine, la loi fédérale du Cloud Act (Clarifying Lawful Overseas Use of Data Act) du 23 mars 2018, permet désormais aux forces de l’ordre ou aux agences de renseignement américains d’obtenir, des opérateurs télécoms et des fournisseurs de services Cloud opérant depuis les États-Unis, l’accès à tout ou partie des informations personnelles ou de contenu stockées sur leurs serveurs, que ces données soient situées aux États-Unis ou à l’étranger, et cela sans que la personne « ciblée » ou que le pays où sont stockées ces données n’en soit informé.

C’est tout à coup assez parlant et beaucoup moins plaisant… n’est-ce pas ?

La réplique, deux mois plus tard, a été conduite par l’Union européenne en votant le RGPD (Règlement Général sur la Protection des Données personnelles) entré en application en mai 2018.

Celui-ci vise à mieux protéger les données personnelles des internautes européens et à renforcer certains de leurs droits, dont la rectification des données par l’utilisateur (CNIL).

Cette mesure, comme vous l’avez compris, avait pour objectif numéro un de renforcer les droits des citoyens européens contre les géants du Net, très souvent américains… en bref, contre « les méchants » !

Une fois le pavé de la protection des données jeté dans la mare, les décideurs ont entre leurs mains celui de la transformation digitale… Et c’est tout l’objet de ce livre. Le sujet de la valorisation des données pour développer l’entreprise reste entier ! À tous les niveaux de l’entreprise, ces données « pleuvent », à tel point qu’il devient impossible pour le cerveau humain de traiter à la fois le volume, la vélocité de production, et de s’assurer de leur véracité sans une aide cognitive… et voilà, la fameuse Intelligence Artificielle qui déboule dans l’entreprise… sans frapper !

Les données apportent des avantages concurrentiels sur tous les fronts : elles permettent notamment d’améliorer l’efficacité opérationnelle, de détecter des failles de sécurité, de repérer des fraudes, d’identifier des axes de développement, d’optimiser les stocks et les flux logistiques, de mieux protéger le « critique » cash-flow face à la crise sanitaire…

Enfin, les données clients se révèlent être un sésame extrêmement précieux pour capter les comportements d’achat, pour créer des circuits de distribution plus courts, pour permettre aux industriels de renouer des contacts forts et intimes avec leurs clients et, enfin, de proposer des offres extrêmement personnalisées.

Les conversations business que j’ai avec nos clients et partenaires stratégiques se focalisent de plus en plus sur les données. C’est maintenant devenu pour les entreprises un axe de différenciation majeur, voire de survie. En cas d’attaque cyber, cela devient critique.

En me projetant dans cinq ou dix ans, donc pas si loin que ça, il me semble possible que nos données soient au cœur de 100 % de nos transactions ! Rien ne passera à côté.

Le xxie siècle sera certainement celui de la révolution de la « data-sécurisée-souveraine-cryptée ». La bataille est bien lancée et elle ne fera de cadeau à personne, individus ou entreprises. Certains vont s’en sortir, d’autres pas… mais lesquels ?

Pendant ce temps, il revient aux dirigeants d’entreprise et aux opérationnels de préparer leur futur dès aujourd’hui : d’embrasser pleinement cette transformation pour avancer durablement.

Bienvenue dans un monde où la data est au cœur des enjeux de création de valeur, du Cloud Public/Souverain, de l’Internet des Objets, de l’Industrie 4.0… bref, de la transformation digitale à marche forcée, cœur de batailles entre les poids hyper-lourds que sont les GAFAM.

Bienvenue dans le monde où vos données valent de l’or !

Jean-François Connan, International Sales Digital Transformation, Cloud, Cyber Security & Strategic Alliances, Thales

Résumé

La donnée est présentée comme le carburant du futur. Pour les entreprises manufacturières, les projets dits d’Internet industriel des objets (IIoT) sont ceux qui permettent d’extraire la valeur de leurs données de production et de leurs produits. Ces projets s’appuient sur un continuum de technologies variées, allant des capteurs jusqu’à l’intelligence artificielle, en passant par les réseaux de télécommunications et les plateformes d’analyse et de stockage. La concaténation de ces technologies permet de suivre le « voyage » de la donnée et de la transformer en information utile pour l’entreprise. L’IIoT, compris comme ce continuum, représente l’ossature de l’industrie 4.0, car il permet l’alignement potentiel des flux physiques et des flux de données.

Les promesses de l’IIoT sont très ambitieuses et s’appliquent à de nombreux domaines : a) le smart metering dans les industries de réseau ; b) l’efficacité opérationnelle de l’usine (diminution des consommations de matières et d’énergie, amélioration du temps de passage et du taux de rendement synthétique, réduction de la taille des lots, etc.), avec des résultats probants ; c) le passage à la maintenance prédictive (ou plus souvent, à une nette amélioration de la maintenance préventive) ; d) la mise à disposition de nouveaux outils numériques pour les opérateurs, avec des interfaces adaptées ; e) les projets de connexion de la supply chain et la traçabilité des produits pour le consommateur. Ces cas d’usage de l’IIoT constituent un levier puissant pour générer des gains de productivité ou de flexibilité sur un site de production ou sur une chaîne de valeur.

Il existe aussi un deuxième champ de promesses de l’IIoT qui offre l’opportunité aux chefs d’entreprises industrielles de regarder différemment leur modèle économique et d’ouvrir des chemins d’avenir. Ce qu’imaginent quelques visionnaires, c’est un glissement du modèle manufacturier vers les services, ainsi que la perspective de revenus supplémentaires issus de la monétisation des données captées. La réflexion ainsi proposée ouvre la voie à un monde « tout-connecté », mais les concrétisations dans le domaine industriel restent pour l’heure embryonnaires et limitées.

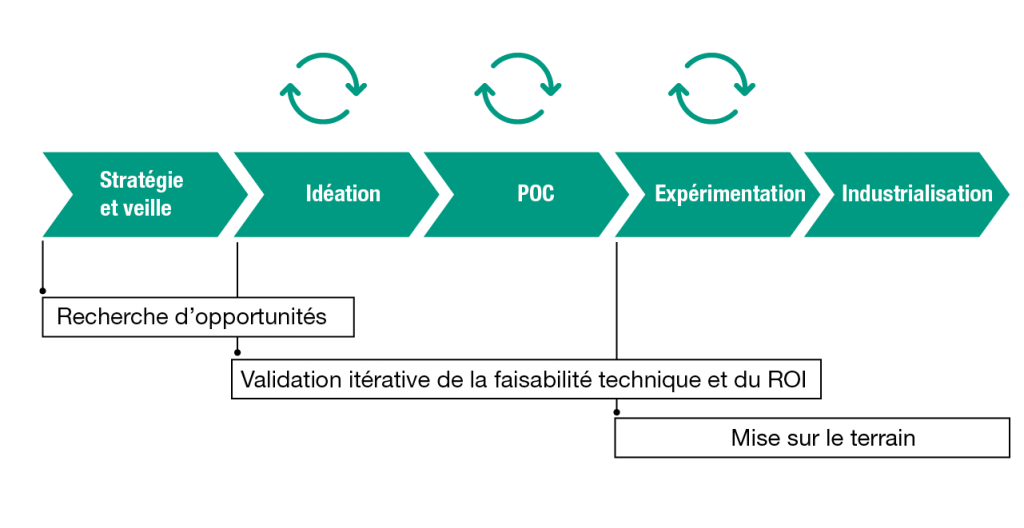

La manière dont les projets IIoT sont gérés est capitale pour leur réussite, et quelques bonnes pratiques à suivre peuvent être recensées. Il faut que ces projets s’insèrent dans une feuille de route numérique cadrée, que leur pilotage puisse inclure plusieurs fonctions stratégiques et que les cas d’usage soient bien définis afin de pouvoir tirer toutes les leçons de l’expérimentation menée. Embarquer les métiers et les équipes, construire une culture et un langage commun entre les DSI et les Opérations, sont des conditions indispensables pour réussir ces projets et une fréquente pierre d’achoppement. Choisir entre le make or buy sur les différentes familles de technologies est propre à chaque entreprise et dépend de sa maturité IT, mais il sera le plus souvent conseillé de choisir, dans un premier temps, des technologies « sur étagère », même si elles nécessitent des adaptations. Enfin, l’attention à la cybersécurité devient une question de plus en plus prégnante à mesure que les équipements matériels sont investis par les logiciels. Sans cette vigilance portée à la gestion de projets, les preuves de concept (ou PoC) risquent fort de le rester et de ne jamais passer à l’échelle.

Le ROI de ces projets est encore mal connu. Les investissements nécessaires pour produire des effets de seuil visibles doivent être cumulatifs sur une certaine durée (entre trois et cinq ans), et certains bénéfices sont indirects et difficiles à mesurer (qualité de vie au travail, satisfaction des collaborateurs, attractivité de l’usine). De nombreuses aides financières nationales et régionales existent pour inciter PME et ETI à enclencher les premiers cas d’usage. En définitive, le premier des bénéfices de ces déploiements pourrait bien être de rester dans la course et de réussir à pérenniser son activité.

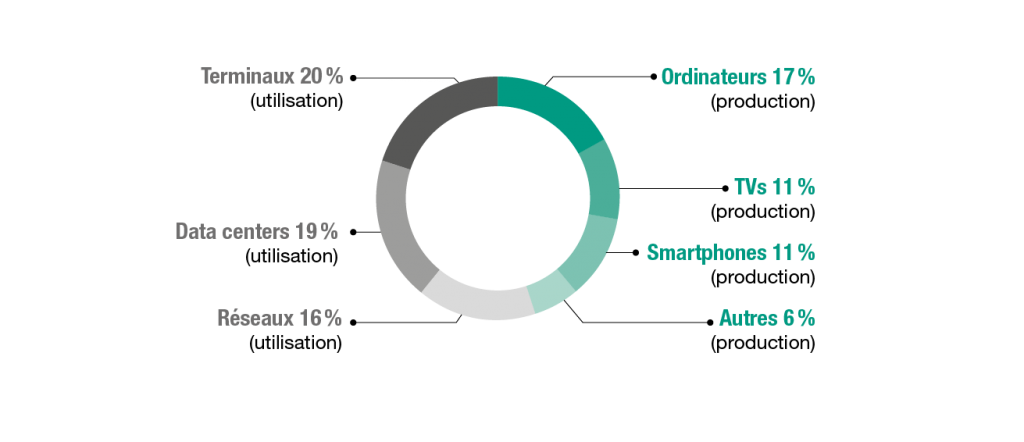

Enfin, l’Internet industriel des objets, et plus généralement les technologies de l’industrie du futur, suscitent des préoccupations sociales et sociétales qui ne peuvent être ignorées. Sur le plan du travail, et selon l’état d’esprit avec lequel les technologies sont mises en œuvre, l’IIoT peut ouvrir la voie à une surveillance généralisée des travailleurs et à un pilotage étroit de leurs actions via les outils numériques, au détriment de leur autonomie. De plus, il permet souvent de faciliter l’intégration de personnels peu qualifiés, battant ainsi en brèche le discours institutionnel sur la montée en compétences des opérateurs de l’usine à l’ère numérique. Sur le plan environnemental, la consommation énergétique de l’Internet des objets et des data centers pose la question de la compatibilité entre transition énergétique et transition numérique. L’enjeu de sobriété numérique est au cœur des débats qui ont récemment entouré en France le développement de la 5G, présentée comme indispensable à l’avènement généralisé de l’industrie 4.0.

Cependant, la crise sanitaire et économique a confirmé les fragilités du tissu industriel français. Celle-ci doit inciter plus que jamais les industriels à un passage à l’acte rapide. Il est vital de ne plus retarder encore la mise en œuvre réelle et à l’échelle de la transformation numérique si souvent annoncée. Elle seule permettra aux entreprises de s’adapter à la complexité et de sortir de cette crise, vivantes et renforcées.

Introduction

Depuis plusieurs années, on entend abondamment parler de l’enjeu que représentent les données : les données personnelles, mais aussi les données publiques, les données d’usage et les données de production. La donnée est présentée comme un nouvel or noir, un carburant de l’économie, dont les data centers seraient les nouvelles raffineries. Sa maîtrise et son exploitation seraient au cœur de la transformation numérique des entreprises « traditionnelles » et de la construction de nouveaux modèles d’affaires, à la manière de ce qu’ont réussi les GAFAM et autres géants du numérique.

Pour les entreprises manufacturières, les données valent-elles vraiment de l’or ? Si oui, pour quels domaines d’application ? Et surtout comment faire pour les capter, les stocker, les protéger, les traiter et en extraire la valeur latente ?

Prenons un exemple. Inditex (Zara), l’un des géants mondiaux de la mode de masse, collecte les données sur les ventes en magasin (points de vente physiques et digitaux). Ces données proviennent des transactions (achats), mais également des informations qualitatives fournies par le personnel et les avis clients (notations des produits et de l’expérience client). Ces données sont utilisées pour gérer les approvisionnements des magasins au rythme de deux réassorts par semaine. Elles alimentent tout le système industriel amont, permettant d’orienter le travail de conception des stylistes et d’impulser la fabrication dans les 14 usines du groupe et le réseau des fournisseurs et sous-traitants partout dans le monde (flux tirés1). Grâce à cette chaîne logistique et de production fortement intégrée à partir des achats et comportements des clients, il s’écoule environ trois semaines entre la décision de commercialiser un vêtement et sa disponibilité dans les boutiques, contre deux à trois mois en moyenne pour les autres acteurs. Son système intégré de bout en bout et communiquant est incontestablement un avantage concurrentiel : l’une des forces de Zara, c’est sa capacité à s’adapter rapidement aux attentes des clients. C’est génial, ça a l’air simple… mais c’est très compliqué.

La promesse centrale de l’industrie 4.0 est bien cette articulation – ce bouclage, pourrait-on dire – entre les flux physiques et les flux digitaux permettant d’assurer la continuité et le pilotage du processus industriel de l’aval vers l’amont et de l’amont vers l’aval, en augmentant la vitesse, la réactivité et la flexibilité, et en assurant une qualité constante.

Aujourd’hui, chez Zara et bien d’autres industriels de la grande consommation, c’est le code barre de l’étiquette qui « parle » au système industriel et logistique. Mais que se passerait-il si la robe elle-même pouvait « parler » – autrement dit si l’objet-robe émettait des données tout au long de sa vie, chaque fois qu’elle est enfilée, passée en machine, prêtée ou revendue ?

Ce qui relève dans cet exemple de la métaphore futuriste est déjà une réalité pour des voitures connectées, des montres connectées, de la domotique ou des compteurs intelligents. Nous entrons ici dans ce qu’il est convenu d’appeler l’Internet des objets ou IoT. Ce champ pluridisciplinaire veut réussir à faire parler entre eux des objets, que ce soit à travers Internet ou de la même manière que s’ils étaient connectés au réseau internet. Ces objets communiquent entre eux (machine to machine ou M2M) mais aussi avec les humains (hommes-machines) : ces derniers donnent des informations aux objets et en reçoivent pour orienter leurs décisions et leurs comportements de façon plus pertinente et efficace. Ces objets génèrent des montagnes de données qui peuvent être traitées et analysées grâce au progrès des capacités de calcul et aux systèmes d’informatique cognitive capables d’en extraire le sens.

En théorie, l’IoT fait donc naître un potentiel d’innovations important tant du point de vue des usages que du commercial ou de la production : mieux comprendre et connaître les clients, innover dans les produits et les services, développer de nouvelles sources de revenus à travers la monétisation des données, etc.

Dans ce livre, nous nous intéressons plus précisément aux cas d’usage de l’Internet des objets appliqué au système de production industriel (ou IIoT – Internet industriel des objets) pour des entreprises manufacturières qui souhaitent atteindre des objectifs tels que l’amélioration de l’efficience du système productif, l’amélioration de leur offre de produits existants ou encore l’offre de nouveaux services liés à ces produits.

Sont donc exclus de notre champ d’investigation les enjeux liés à la conception d’objets connectés destinés au grand public, par exemple dans le domaine de la santé, des services de mobilité, des loisirs ou des médias. Pour reprendre notre exemple de Zara, nous ne traiterons pas de la robe connectée, mais plus prosaïquement, de la manière dont l’Internet industriel des objets peut améliorer encore l’efficacité de production de la robe, développer des services autour de la robe et changer les manières de travailler pour produire cette robe.

L’Internet industriel des objets ne représente encore qu’une part mineure des investissements dans l’IoT, mais il est extrêmement prometteur. Dans le monde, 189 milliards de dollars ont été investis en 2018 en solutions d’IoT industriel sur 772 milliards pour l’ensemble du marché mondial IoT (IDC 2017), soit à peu près un quart, avec une croissance moyenne estimée entre 15 et 20 % ces dernières années. En Europe, les dépenses totales IoT étaient prévues pour dépasser 241 milliards de dollars en 2022 (IDC, 2018). Les industries manufacturières dépenseraient autour de 20 milliards de dollars dans ces projets, soit moins d’un dixième, ce qui peut sembler comparativement faible.

L’objet de cette étude est de proposer un bilan d’étape sur les promesses de cette famille de technologies pour les industriels, sur ses effets réellement mesurables sur le terrain et sur de possibles écarts, permanents ou provisoires, entre théorie et pratique. Elle a pour but de livrer des conseils utiles aux dirigeants et responsables industriels voulant se lancer dans cette voie, leur signalant les bénéfices qu’ils peuvent raisonnablement en attendre, les difficultés à surmonter et quelques erreurs à éviter. A contrario, elle n’a pas vocation à s’adresser aux technologues et spécialistes des systèmes d’information. Elle fait œuvre de vulgarisation et n’entre pas dans le détail des technologies disponibles ou attendues sur le marché, mais s’intéresse aux enjeux « business » et aux enseignements des premiers cas d’usage, afin d’aider en pratique les responsables industriels confrontés à cette question.

- 1 – Un flux de production est dit « tiré » lorsque la production (nature et volume) est organisée en fonction de la demande (constatée ou anticipée avec le plus de précision et de réactivité possible). Le but est de ne produire que ce qui sera vendu.

L’Internet industriel des objets, lignes de repère

L’Internet industriel des objets n’est pas un domaine facile à cerner. En croisant plusieurs définitions, on peut dire sommairement que :

L’IIoT est un sous-ensemble de l’internet des objets permettant de faire communiquer entre eux des « objets » industriels (machines, produits en cours de fabrication, approvisionnements, systèmes d’information des fournisseurs et des clients, infrastructures et bâtiments), afin d’améliorer l’efficacité du système industriel et de rechercher de nouvelles sources de valorisation des données ainsi captées.

Industrie 4.0 et besoins des industriels

Une façon d’entrer dans l’IIoT consiste à partir des besoins des industriels. Comme l’a souligné une étude conduite par Bpifrance Le Lab2, ceux-ci sont souvent désarçonnés et perplexes quand on leur parle des promesses de l’industrie 4.0 sous l’angle des seules technologies. Ils comprennent bien mieux de quoi il retourne dès lors qu’on évoque la continuité des processus dans l’usine et aux interfaces de l’usine, c’est-à-dire le pilotage de la production par des flux d’informations, la capacité à produire des séries courtes de façon rentable, ou encore lorsqu’on parle de productivité, sécurité, traçabilité et qualité des process et des produits (voir Figure 1.1). C’est à ce niveau que se situent les enjeux « business » perçus par les industriels.

Figure 1.1 – L’industrie du futur vue par les industriels

Source : Bpifrance. https://www.bpifrance.fr/A-la-une/Actualites/Comprendre-l-industrie-du-futur-44825. Consulté le 15 juin 2020

Si l’on définit l’IIoT comme ce qui permet l’interconnexion entre les machines, les hommes et les systèmes d’information dans une logique d’alignement des flux physiques et des flux de données, alors l’IIoT n’est pas une simple brique technologique de l’industrie 4.0 mais la pierre angulaire de la transformation des usines. Bien des industriels, à la manière de modernes M. Jourdain, ont commencé à faire de l’IIoT sans le savoir ni jamais utiliser ce terme.

L’avis de l’expert − Michaël Valentin, associé chez Opeo, auteur de Hyper-manufacturing3

Quelle est la place de l’IIoT dans l’industrie 4.0 ?

L’industrie 4.0 comprend, selon moi, trois types de technologies qui fondent des promesses différentes et complémentaires :

1. Des technologies physiques innovantes qui incorporent de l’automatisation, de l’électronique et de la connectivité comme la robotique ou l’impression 3D. Elles ont un effet essentiellement local et visent principalement une amélioration des process au sein du site industriel.

2. L’IIoT qui permet d’assurer l’interconnexion des machines, hommes et architecture IT. C’est une promesse centrale et structurante puisqu’elle fonde l’articulation du monde physique avec le monde digital au sein de l’usine et bien au-delà.

3. Tout ce qui concerne le stockage, la structuration et le traitement de la donnée à travers une couche de système cognitif ou d’intelligence artificielle, qui fonde l’analyse et la prise de décision, donnée qui pourrait aussi être à la source de nouveaux modèles d’affaires tournés vers les services.

Il y a une continuité évidente entre 2 et 3 pour structurer l’industrie du futur, même si elle n’est pas forcément facile à mettre en œuvre.

Un continuum de technologies

Loin d’être simplement une technologie parmi d’autres à côté de la robotique, de la réalité virtuelle et augmentée, de la fabrication additive, du cloud, du big data ou de l’intelligence artificielle4, l’IIoT est en réalité un concept qui fait appel à un continuum de technologies.

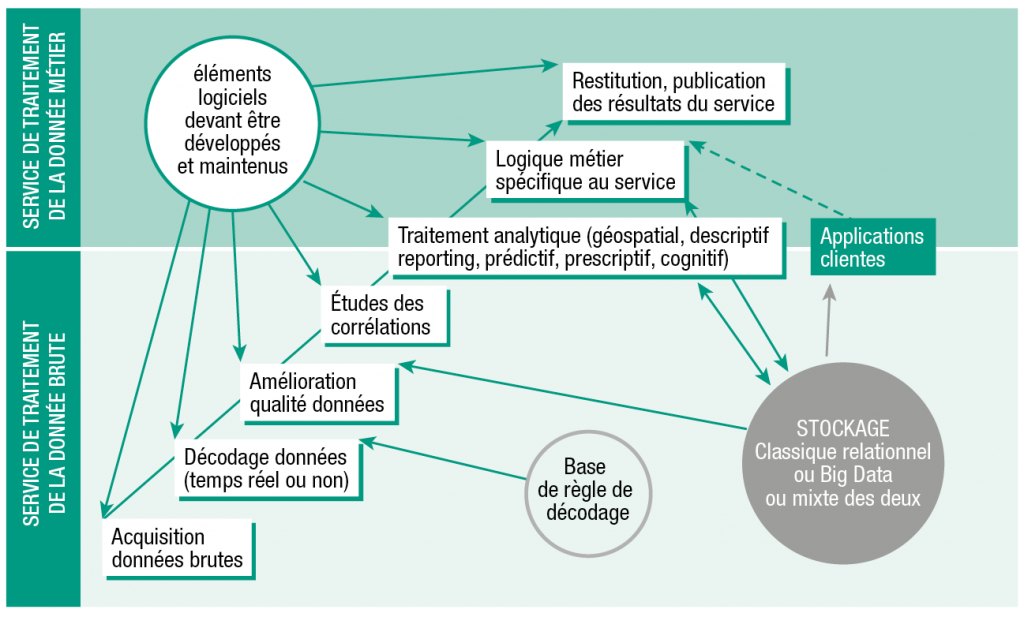

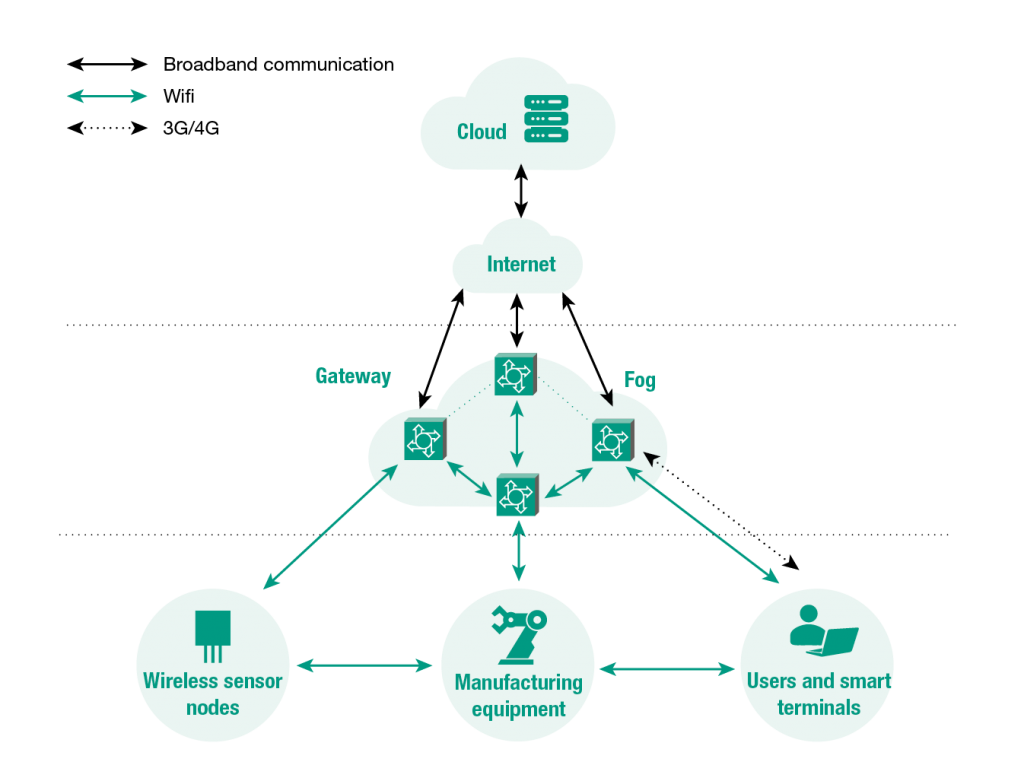

Il est donc parfois difficile d’en appréhender clairement les contours et les limites, puisque chaque fournisseur − et ce sont eux qui en parlent le plus – tend à mettre l’accent sur le champ technologique qu’il maîtrise le mieux. Ces différentes technologies, une fois articulées, visent à collecter, transmettre, traiter et communiquer un « objet » essentiel qui est la donnée, selon la séquence suivante :

• Capter les données émises par des objets physiques (équipements, machines, bâtiments) grâce à des capteurs, des caméras et autres devices.

• Transmettre les données sans intervention humaine grâce à des systèmes de télécommunications majoritairement non filaires (Bluetooth, RFID, NFC, Wi-Fi, 3G, 4G, 5G).

• Interfacer les systèmes qui produisent et collectent les données grâce à toutes sortes de « passerelles » (ou middleware).

• Stocker, sauvegarder, archiver et protéger ces données de toute nature sur des plateformes (cloud, datalake, data warehouse).

• Transformer les données en information : nettoyer, croiser et corréler les données via des systèmes d’information et y ajouter, le cas échéant, une couche d’informatique cognitive (machine learning) afin de leur donner du sens, en fonction des besoins.

• Restituer les informations via la conception d’applications (logiciels de dataviz, tableaux de bord) adaptées aux besoins de chaque type d’utilisateurs.

• Lire les informations sur différents types de terminaux (écrans géants, ordinateurs, tablettes, smartphones, montres connectées, etc.)

La sécurité des données est un élément à part entière, présent à chacune des étapes de ce continuum.

Figure 1.2 – Les étapes d’un projet IIoT

Source : digora.com

La diversité des technologies impliquées à toutes les étapes engendre donc par nature une assez grande complexité des projets IIoT. Il est facile de se noyer rapidement dans le choix et la concaténation des solutions technologiques et de perdre de vue le projet « business » auquel on souhaite répondre.

Un écosystème de fournisseurs très large

À la variété des technologies impliquées correspond un écosystème de fournisseurs très large.

On trouve d’abord les fournisseurs historiques d’automatismes, équipements machines, lignes de production, robots et de la couche logicielle qui permet de les opérer et contrôler (Operations Technology ou OT ou technologies d’exploitation), tels que Schneider, Siemens, Bosch, Omron, etc.

Il est important de garder à l’esprit que l’immense majorité des machines qui équipent les usines ne sont pas des ordinateurs : elles n’ont pas été à l’origine conçues pour émettre des données, d’où la nécessité de les doter de capteurs et de passerelles pour les rendre « communicantes ». Ce n’est que plus récemment que les fournisseurs ont incorporé directement des technologies « communicantes » dans le hardware. Coexistent donc dans les usines des générations d’équipements non seulement de marques différentes mais encore avec des niveaux de maturité très variables, qui doivent « communiquer » entre eux et avec les systèmes d’information selon des protocoles différenciés.

Les acteurs historiques des technologies de l’information (IT) (IBM, Cisco, SAP, etc.) ont été rejoints par les acteurs du numérique, tels que Microsoft, Google ou Amazon, qui les concurrencent sur certains aspects de leur offre comme le cloud, le middleware (permettant les communications entre les systèmes) ou les systèmes d’intelligence cognitive à base de machine learning. Les frontières entre les différents types d’acteurs de l’IT deviennent de plus en plus poreuses : dans cette chaîne de valeur, il est souvent compliqué de savoir qui fait exactement quoi et jusqu’où.

Sur ce point aussi, les entreprises doivent faire face à un problème de legacy IT, c’est-à-dire d’héritage technique, avec la présence de systèmes informatiques hérités, souvent archaïques, mais difficiles à « débrancher », qui doivent pouvoir s’interfacer avec des applicatifs souples et beaucoup moins structurés qu’auparavant, occasionnant de nombreux problèmes d’interfaçage et de compatibilité.

Les rôles respectifs de l’OT et de l’IT sont donc de moins en moins cloisonnés. Les frontières se brouillent et cette tendance s’accélère depuis quelques années. Les fournisseurs OT proposent à leurs clients des solutions IT, et les fournisseurs IT fournissent des solutions qui incluent de l’OT.

On constate que bon nombre de matériels et infrastructures informatiques « physiques » sont maintenant disponibles de manière « virtuelle », ce qui contribue à rendre cette frontière entre IT et OT extrêmement ténue. Nombreux sont les logiciels qui apportent un service similaire à ce que le matériel délivrait, il y a encore quelques années. Les fonctions réseau sont les premières à subir cette digitalisation. Nombre de robots ou outils numériques embarquent nativement des protocoles de communication. À titre d’exemple, cette convergence a notamment un très fort impact pour le monde des télécommunications qui doit lui-même s’adapter à ces « Virtual Function Networks ». Il y a quelques années, les fonctions réseaux des opérateurs étaient livrées sous forme de boîtiers matériels physiques (switch, routeurs, passerelles et autres firewalls, etc.), elles existent désormais en tant que logiciels virtuels qu’il est plus facile de mettre en œuvre dans des équipements informatiques traditionnels. Autre exemple dans le monde du grand public, les smartphones qui ont aujourd’hui besoin de cartes SIM physiques pour fonctionner intègreront demain une carte SIM virtuelle, et ils ont tous la capacité d’agir comme des routeurs et point d’accès de connexion. Dès lors, les capacités IIoT sont devenues des arguments de vente à part entière pour les fabricants d’outils de production et autres systèmes de production.

Cette convergence entre l’OT et l’IT conduit les grands acteurs du secteur à constituer des alliances technologiques et commerciales ad hoc. Ces alliances se reconfigurent selon les besoins spécifiques des projets. Des vitrines technologiques ou des démonstrateurs permettent de montrer aux futurs clients comment ces technologies issues de différents types de fournisseurs peuvent être combinées au service d’un projet (voir encadrés : IBM FabLab et Collectif Continuité Numérique).

Un exemple : l’IBM FabLab

Parce qu’une usine ne peut pas interrompre ses lignes de production pour tester des solutions d’optimisation, l’IBM FabLab reconstitue l’environnement technologique de l’usine pour chercher et expérimenter des solutions innovantes. Il intègre les acteurs clés d’un projet : client et partenaires technologiques. Aux solutions d’IBM en matière d’IoT, d’intelligence artificielle et de cloud, s’ajoutent celles de partenaires pour les réseaux de communication, le hardware ou les automates. Ces collaborations permettent de mettre au point des prototypes fonctionnels.

Un exemple : le Collectif Continuité numérique

et la « concept machine » Axelle

Né en 2016, le Collectif Continuité numérique (CNN) réunit huit leaders industriels et informatiques : Festo, SAP, Inetum, ifm electronic, Phoenix Contact, SICK, SEW Usocome et Stäubli, qui opèrent depuis le capteur jusqu’au pilotage intelligent des usines. Longtemps, les mondes de l’OT et de l’IT ont évolué parallèlement. Aujourd’hui, ils convergent pour mettre au point des solutions technologiques interopérables afin d’aider les industriels à évoluer vers l’usine 4.0, même à partir d’un parc machines hétérogène. En octobre 2020, le CNN a lancé la « concept machine » Axelle, une petite ligne de production opérationnelle fabriquée par ATS, une société d’ingénierie industrielle bourguignonne. Axelle matérialise la convergence OT-IT et vise à montrer aux entreprises manufacturières qu’il n’est pas nécessaire de renouveler de fond en comble son parc machines pour le faire communiquer différemment et capitaliser ainsi sur les données. Le CNN se présente comme un modèle de collaboration industrielle, y compris entre concurrents. Il ne commercialise aucune solution intégrée, mais offre un cadre d’action pour combiner chez un client plusieurs solutions, ATS pouvant, le cas échéant, jouer un rôle d’intégrateur de solutions.

À cette liste de fournisseurs, s’ajoutent encore les opérateurs de réseaux non filaires qui peuvent être des opérateurs cellulaires généralistes (Orange Business Services, Bouygues Entreprise, SFR Business, etc.) ou des acteurs utilisant des protocoles dédiés à l’Internet des objets (alliance LoRa, Sigfox, etc.).

Zoom sur… LoRa et LoRaWAN

LoRaWAN est un protocole de télécommunication permettant la communication à bas débit, par radio, d’objets à faible consommation électrique, communiquant selon la technologie LoRa et connectés à l’Internet via des passerelles, et participant ainsi à l’Internet des objets. La cible de LoRaWAN est clairement les communications longues portées à bas coût et basse consommation plutôt que les communications à débit élevé.

Enfin, il existe un nombre très important de start-up spécialisées – dont certaines incorporent des briques technologiques des gros acteurs du secteur −, consultants ou experts intégrateurs qui gravitent autour de ces projets, selon les besoins.

La complexité du système fournisseurs de l’IIoT constitue en soi une barrière à l’entrée pour de nombreux industriels. Nous verrons qu’il est important de choisir des fournisseurs qui soient adaptés à la nature et à la culture de l’entreprise.

L’avis de l’expert − Samir Djendoubi, expert IIoT indépendant

Pourquoi les projets IIoT sont-ils complexes ?

L’IIoT repose sur la concaténation de quatre blocs de technologies, globalement assez anciennes :

1. des systèmes embarqués ;

2. des réseaux de télécommunications ;

3. du middleware, c’est-à-dire des solutions logicielles qui assurent les interfaces entre les systèmes ou encore qui façonnent les données pour leur donner du sens ;

4. des solutions applicatives capables d’amener la donnée vers les utilisateurs.

Articuler ces quatre blocs de technologies n’a déjà rien d’évident. Mais en outre, elles doivent être placées au service d’un objectif business qui nécessite de comprendre assez finement les processus industriels « métiers ». Il faut donc être capable de « traduire » les besoins des métiers en solutions technologiques, et inversement. Ce qui nécessite d’être pertinent à la fois sur le socle technologique et la compréhension critique des solutions des fournisseurs, mais aussi sur la réalité du terrain industriel.

Des promesses très ambitieuses

À lire les sites, articles, conférences, des acteurs et accompagnateurs de l’Internet industriel des objets, les promesses de ces technologies sont considérables.

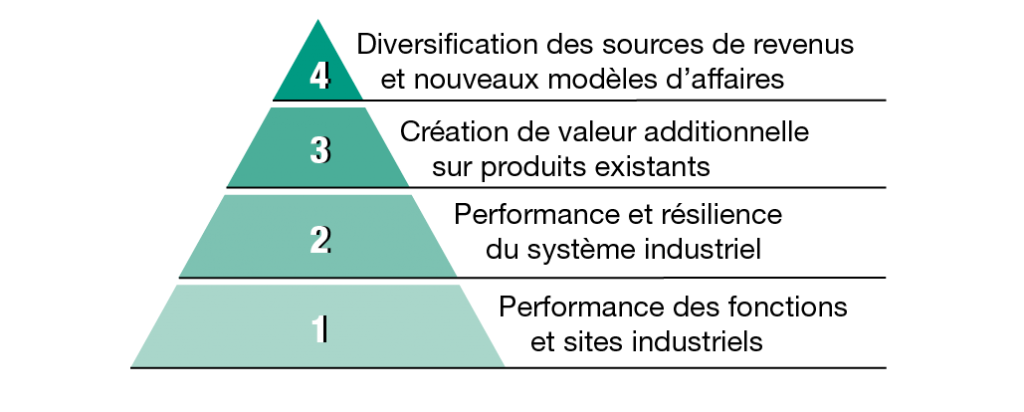

Elles peuvent être regroupées en quatre grandes catégories (voir figure 1.3) :

• Améliorer l’efficacité opérationnelle directe et indirecte d’une fonction industrielle ou d’un site : réduction des délais, meilleure utilisation des machines, diminution des ressources employées (efforts humains, matières, énergie), information en temps réel et partagée, etc.

• Améliorer l’efficacité du système industriel s’étendant des fournisseurs jusqu’aux clients : sécurisation des approvisionnements, logistique et transport, planification industrielle, meilleure utilisation des actifs, etc.

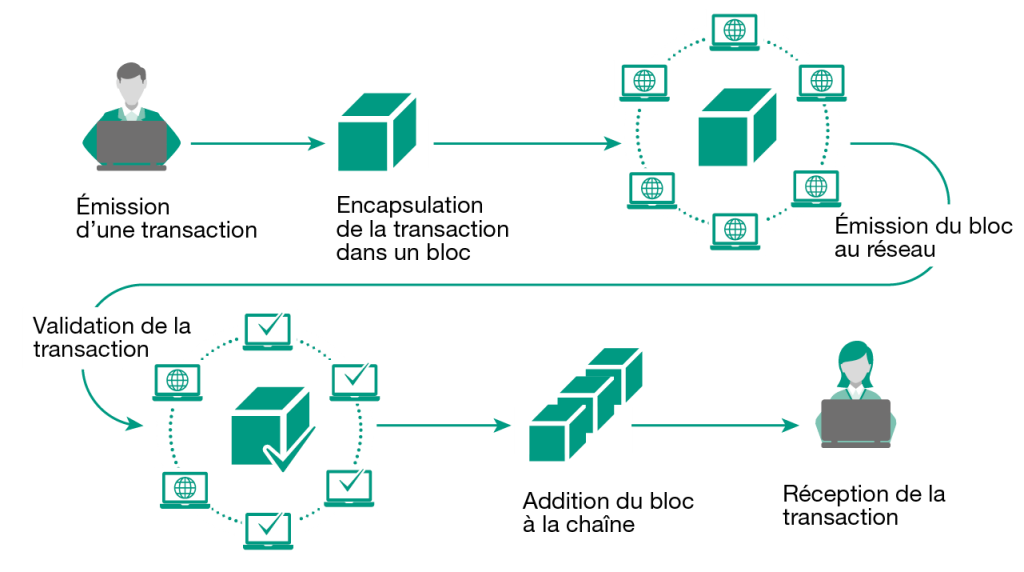

• Créer de la valeur additionnelle sur les produits existants : stabilisation des recettes (agro-alimentaire, cosmétiques) pour une meilleure qualité, traçabilité via, par exemple, des puces RFID embarquées dans les produits conjuguées à des blockchains, transparence vis-à-vis des consommateurs sur la composition et la provenance des produits, etc.

• Créer de nouvelles sources de revenus ou faire évoluer les modèles d’affaires : monétisation des données collectées, création de nouveaux services innovants à partir des données.

Figure 1.3 – Les 4 grandes catégories de promesses de l’IIoT

Ces quatre grandes catégories de promesses recouvrent de multiples sous-objectifs qui peuvent se traduire, chacun, par un projet IIoT spécifique. Nous verrons qu’il y a souvent une logique de progressivité et de petits pas dans la manière d’apprivoiser l’IIoT. Compte tenu de la complexité de ces projets, ceux-ci commencent souvent par une expérimentation sur un périmètre très circonscrit ou peuvent ne concerner qu’un problème ponctuel à résoudre. Petit à petit, les projets s’enchaînent et s’étendent jusqu’à concerner toute une usine, voire tout un système productif. Sans en avoir la preuve formelle, nous constatons que les projets réussissent mieux lorsqu’ils s’inscrivent dans une vision stratégique et un projet global de transformation digitale de l’entreprise (feuille de route).

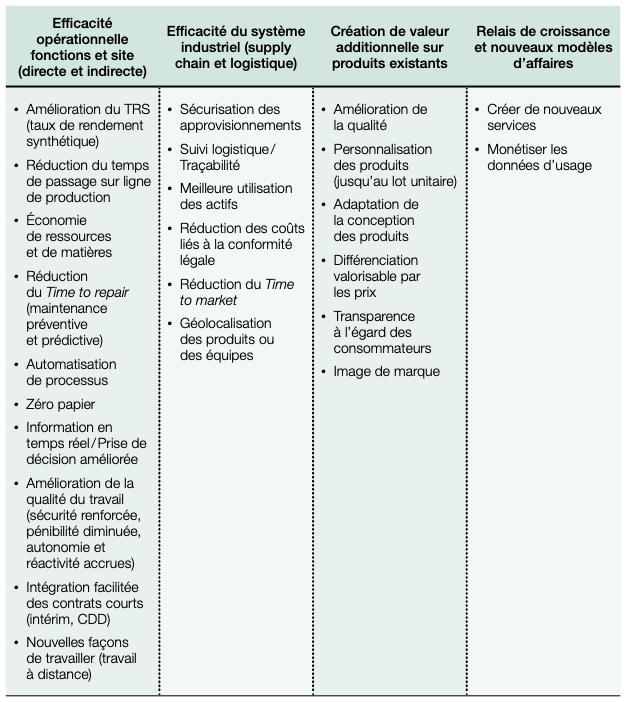

Les projets IIoT ayant souvent vocation à poursuivre plusieurs bénéfices conjoints, la structuration en liste ci-après a uniquement une vertu pédagogique (voir figure 1.4).

Figure 1.4 – Une grande diversité de bénéfices directs et indirects

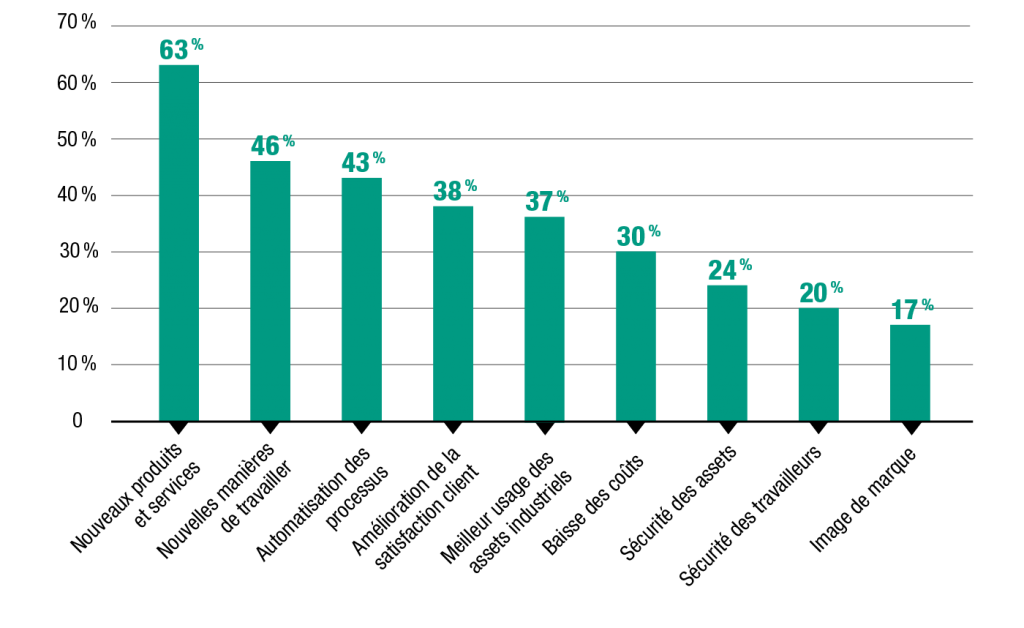

En 2017, une étude menée conjointement par Wavestone, EBG et Agrion auprès de 90 responsables et décideurs au sein d’entreprises industrielles, principalement de l’énergie, de la logistique et des transports, de la construction aéronautique, ferroviaire et navale, indiquait que l’IIoT était perçu comme une source de transformation pour : créer de nouveaux services (63 %), trouver de nouvelles manières de travailler (46 %) ou automatiser les processus (43 %) (voir figure 1.5).

Figure 1.5 – Les bénéfices attendus de déploiements IoT selon une enquête Wavestone (2017)

Source : « L’IoT industriel : du POC à l’industrialisation », Wavestone, ebg, Agrion, 2017

- 2 – Bpifrance Le Lab, « L’avenir de l’industrie : le regard des dirigeants de PME-ETI sur l’industrie du futur et le futur de l’industrie », 2018.

- 3 – M. Valentin, Hyper-manufacturing, L’après Lean, Dunod, 2020.

- 4 – Voir, par exemple, T. Bidet-Mayer, L’industrie du futur : une compétition mondiale, Les Notes de La Fabrique, 2016.

Les promesses de l’IIoT à l’épreuve du réel

Si les promesses de l’IIoT sont ambitieuses, les cas d’usage auxquels notre enquête nous a permis d’avoir accès restent pour l’heure concentrés sur quelques domaines d’application. La plupart de ces projets ont moins de cinq ans.

L’absence de recul peut expliquer la réticence des entreprises à être citées, à communiquer le montant de leurs investissements ou la mesure des retombées de ces projets. Beaucoup de projets sont encore à un stade expérimental avec des déploiements souvent plus longs qu’initialement anticipé.

Ces cas d’usage témoignent cependant du potentiel que présentent les projets IIoT.

Smart metering

Pour 100 projets IIoT, 70 concernent le « smart metering » ou compteurs qui permettent d’effectuer de la mesure à distance. Ces compteurs intelligents sont capables de capter la donnée, puis de l’envoyer à des plateformes où elle sera stockée, sécurisée et partagée, notamment pour suivre en temps réel les consommations, équilibrer l’offre et la demande, maîtriser ou lisser les consommations, produire des factures, repérer les pannes ou défauts du réseau, faire des économies d’énergie, affiner les modèles de prévision, etc. Ces déploiements concernent prioritairement les opérateurs de réseaux (énergie, eau, transports et bâtiments)5. Certains exemples étant assez connus (compteurs Linky, compteurs d’eau intelligents, par exemple) et ces entreprises n’étant pas strictement des entreprises manufacturières, nous n’approfondissons pas ce domaine d’application dans cet ouvrage.

Efficacité opérationnelle de l’usine

C’est l’un des sujets les plus prometteurs et c’est aussi celui qui offre le plus d’opportunités de transformation et de progrès pour les ETI et PME.

La vie d’une usine est une suite d’aléas. La performance des lignes de production est affectée par de nombreux facteurs : les temps d’attente (on attend des composants, des emballages, etc.), les micro-arrêts ou pertes de cadence, la variabilité des matières premières qui peut influer sur les réactions des machines, les problèmes de qualité, les changements de produits sur la ligne ou encore les pannes. En cumul, tous ces « incidents » peuvent finir par représenter de 5 à 30 % de performance en moins pour un site.

Une tendance de fond affecte également la performance : la réduction de la taille des lots, pouvant aller jusqu’à l’extrême personnalisation des produits (lots unitaires). Cette réduction de la taille des lots augmente la fréquence des changements de séries sur les lignes de production. Lors d’un changement de fabrication, la partie mise en train (l’amorce de la fabrication) génère une quantité importante de rebuts (non qualité). Le but est de diminuer le temps de passage d’une série à une autre, en obtenant des changements d’outils rapides ou des réglages instantanés, pour arriver plus vite à un produit « bon du premier coup ». Si les temps de changement de série deviennent plus courts, le taux de rendement synthétique (TRS)6 s’améliore. Les consommations de matières, d’énergie et de travail, se réduisent, ce qui a un impact direct sur les coûts. Le seuil de rentabilité du produit, appelé aussi point mort, peut ainsi être abaissé, ce qui permet d’envisager des lots de plus en plus petits.

La plupart du temps, les opérateurs comme les directeurs de production ne savent pas avec exactitude d’où proviennent les pertes qu’ils subissent. Mettre en place des solutions IIoT peut permettre d’objectiver les sources de pertes et de gagner en performance sur de multiples critères. Il s’agit en fait de piloter toujours davantage l’usine sur la base de données. On retrouve ici l’une des grandes leçons des GAFAM et une source d’inspiration : les données valent mieux qu’une intuition.

« Ces entreprises [les GAFAM], qui ont été immédiatement numériques, sont pilotées par les faits, les tableaux de bord, les chiffres. Il y a des sondes un peu partout, dans le parcours client par exemple. L’impact d’une décision peut être analysé très rapidement. Pour ne donner qu’un exemple, Amazon a montré le lien entre le temps d’affichage d’une page et le taux de conversion d’une commande. Ces entreprises sont dans l’optimisation permanente et instantanée grâce à toutes les données recueillies. »

Fabernovel, Gafanomics7

De façon très simplifiée, un projet IIoT pour l’usine comporte plusieurs séquences. La première consiste à faire « parler » les machines qui n’ont en général pas été conçues pour fournir de la donnée. Ce premier niveau de collecte des données machines va permettre de fournir aux opérateurs une première série d’informations pour mieux comprendre ce qui se passe sur leur machine ou sur leur ligne. Une fois ces données agrégées, il est possible « d’historiser » les incidents. On peut produire de simples diagrammes de Pareto permettant de visualiser les causes les plus importantes des arrêts machines, de formuler les problèmes et de les résoudre les uns après les autres, en se basant sur des faits, plutôt que sur des opinions ou des intuitions. Enfin, la troisième séquence consiste à nourrir un système de machine learning avec les données ainsi recueillies. L’algorithme va alors procéder à des liens et à des corrélations entre les données de façon à formuler des recommandations. Ces recommandations peuvent ensuite être testées pour s’assurer de leur validité, et ces tests viendront à leur tour alimenter le système pour améliorer la qualité du modèle prédictif.

C’est à un projet smart factory appliqué à toute une usine, processus par processus et fonction par fonction, que s’est attelé depuis sept ans Olivier Maho, responsable industrie et logistique de BG Security au sein du groupe Somfy.

Business Case n°1 – BG Security – Piloter la performance par les données industrielles

Fiche d’identité

• Métier : Systèmes électroniques connectés pour la maison

• Site industriel : Rumilly (40 personnes)

• Groupe : Somfy (motorisations de stores électriques et volets roulants,

portes et portails, maison connectée)

• Salariés groupe : 8 000

• CA groupe : 1 milliard d’euros dont 75 % réalisé à l’étranger

Au sein du groupe Somfy, BG Security est le centre de profit qui traite des systèmes pour la maison connectée. Le site de Rumilly, près d’Annecy, est la plus petite des usines du groupe (40 personnes), mais aussi la plus spécialisée. Elle fabrique des systèmes électroniques connectés pour la maison – alarmes, box domotique, visiophones et caméras de sécurité – pour un marché d’installateurs professionnels et une variété de distributeurs (grandes surfaces de bricolage, grandes surfaces spécialisées et e-commerce), selon un modèle BtoBtoC. Elle gère environ 1000 références de composants pour 350 références de produits finis.

Lorsqu’Olivier Maho devient responsable industrie et logistique chez BG Security en 2014, le site de Rumilly n’est pas encore passé au Lean manufacturing. C’est le début d’un projet de transformation de l’outil industriel qui, avec une logique de petit pas, va faire du site de Rumilly une « vitrine de l’industrie du futur », label que l’usine recevra à fin 2018.

Dès le départ, l’intention est de numériser la chaîne de valeur de l’usine « end to end », depuis les fournisseurs jusqu’aux clients. L’usine veut devenir un centre d’excellence pour les usines du groupe : aux produits connectés qu’elle fabrique doit correspondre une usine-modèle connectée. Les concurrents de Somfy sont des géants comme Nest de Google, et l’ETI savoyarde, en dépit de sa spectaculaire internationalisation, ne peut rivaliser avec eux sur le terrain de la production de masse, mais doit se concentrer sur la personnalisation (sur-mesure) de produits à coût compétitif, ce qui implique des séries courtes et la capacité à être très flexible en matière de production.

Un projet Smart Factory centré sur la data de l’usine

La transformation va être articulée en trois grandes phases.

De juillet 2014 à mai 2016, l’usine intègre les bases du Lean manufacturing pour dessiner, optimiser et maîtriser ses processus. Cette étape n’est pas conçue comme une fin en soi, mais comme un préalable nécessaire pour éviter de numériser des gaspillages. C’est à cette étape que sont introduits entre autres le suivi du TRS (taux de rendement synthétique) sur la base de fiches papier et fichiers Excel, ainsi que les AIC (animations à intervalle court), caractéristiques du Lean manufacturing.

De mai 2016 à octobre 2018 se déploie le projet Smart Factory avec la mise en place d’une nouvelle architecture SI, la mise en réseau de l’ensemble des machines, la numérisation des processus et procédés, et le passage au zéro papier.

À compter de 2019 s’est ouverte une nouvelle étape marquant le passage de la Smart à l’Intelligent Factory qui a pour but de mieux exploiter la data, de passer à des modèles plus prédictifs incluant une couche d’informatique cognitive (IA) et de connecter la supply chain. Cette étape est toujours en cours.

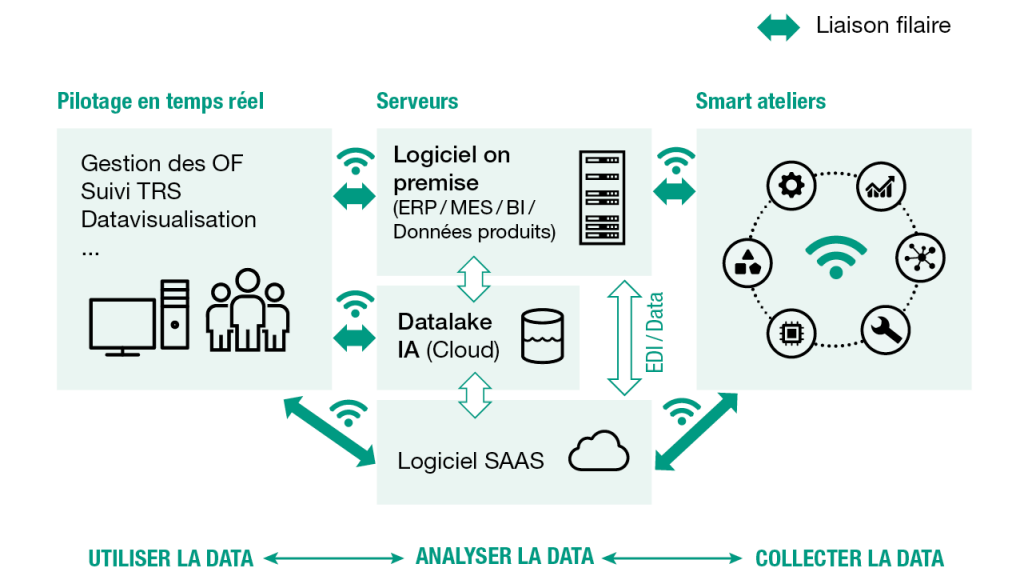

Le projet est entièrement centré autour de la donnée :

1. Collecter les données industrielles et logistiques : données de production et données des produits.

2. Gérer et analyser les données de façon dynamique et en temps réel.

3. Visualiser les données en temps réel pour piloter la performance.

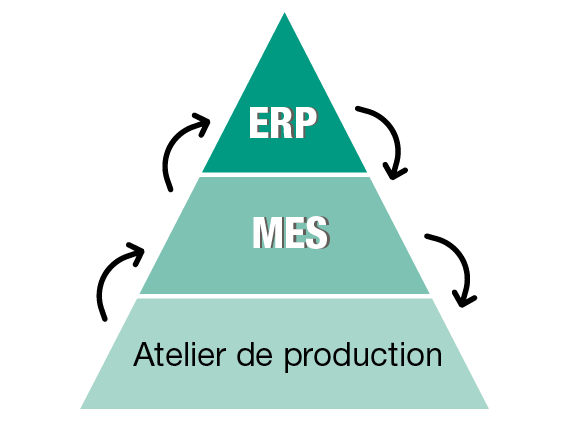

Architecture SI globale

L’architecture SI est marquée par l’introduction d’un MES (Manufacturing Execution System) – qui désigne un logiciel de pilotage de la production capable de collecter en temps réel les données de production de l’usine –, là où il n’y avait auparavant qu’un ERP. Les ERP s’adressent traditionnellement plutôt aux fonctions tertiaires qui font de l’analyse après coup, alors que le MES collecte et fournit des informations qui intéressent directement le fonctionnement de l’atelier.

L’ERP travaille à la demi-journée et traite les données techniques des produits, la gestion des stocks, les commandes et les ordres de fabrication. Le MES travaille à la seconde, à l’interface avec les opérateurs, et traite la gestion de la production, l’ordonnancement, le pilotage du TRS, la qualité et la maintenance. Les ordres de fabrication descendent de l’ERP vers le MES, puis vers les terminaux de l’atelier, et les informations remontent en sens inverse, en temps réel.

En plus des serveurs (ERP, MES et Bases Produits), Olivier Maho a anticipé l’étape suivante, en créant d’emblée un data lake dans le cloud qui stocke les données de toute nature, permettant à terme d’envisager des traitements plus sophistiqués à base de machine learning (ordonnancement, maintenance ou qualité prédictives).

Parallèlement, c’est au niveau de l’atelier que sont collectées les données machines grâce à des capteurs placés aux bons endroits. Toutes les machines de l’atelier sont connectées entre elles en full wifi, ce qui donne de la flexibilité pour reconfigurer les lignes sans avoir à déplacer des câbles. Tous les opérateurs, qui, à Rumilly, sont exclusivement des opératrices, sont équipés de tablettes qui interagissent avec le système.

Différents niveaux de restitution des données ont été définis, avec des interfaces hommes-machines adaptés à la visualisation des informations pertinentes pour chacun : le niveau de l’opérateur, des services supports et du management de l’usine.

Architecture globale d’une Usine Lean à une Smart Factory

Source : Olivier Maho, Somfy.

Une fois l’architecture globale définie, la transformation va ensuite être séquencée en plusieurs étapes afin d’aller rechercher de la performance dans chaque domaine de l’usine. Pour Olivier Maho, cette politique des « petits pas » est essentielle à la réussite du projet, car elle permet de convaincre et d’engager les équipes au vu des résultats et des succès des étapes précédentes.

Premier groupe de sujets traités : TRS et changements de séries

La première étape du projet va s’intéresser à l’amélioration du TRS – indicateur synthétique qui permet de suivre le taux d’utilisation des machines et des pertes de production – via, entre autres, la capacité à effectuer plus rapidement et avec plus de fiabilité les changements de séries sur les lignes.

Auparavant, il y avait des feuilles de TRS remplies manuellement et consolidée dans des fichiers Excel, il y avait aussi des fiches papier au poste décrivant le montage de chaque type de produit. Désormais, tout se trouve dans le MES. Premier résultat : l’usine zéro papier devient une réalité. Débarrassées de ces tâches fastidieuses de saisie et de doublons, les équipes voient leur temps libéré pour faire un travail plus centré sur l’amélioration continue et le contrôle qualité.

Plus les changements de série sont rapides et fluides, plus le TRS s’améliore. Le pilotage usine gère les dossiers de fabrication ; la ligne de production se configure automatiquement selon les ordres de fabrication émis, puis envoie un signal pour dire qu’elle est prête. La nomenclature à suivre apparaît alors sur la tablette de l’opératrice, sur laquelle elle peut « appeler » la fiche opératoire et suivre en temps réel sa propre performance… Aux dires d’Olivier Maho, ce suivi n’a pas été perçu comme un outil de « flicage », mais comme un instrument d’autocontrôle et de progrès personnel.

Résultats de cette première étape : des gains de rapidité lors des changements de séries, des opératrices beaucoup plus autonomes, la suppression des contrôles croisés au démarrage d’une série et la réduction du nombre d’erreurs liées à des problèmes de production. Et au final, un gain de 5 points de TRS, de 82,3 à 87,5, soit une réduction de 30 % du temps pendant lequel les machines ne produisent pas !

Deuxième groupe de sujets traités : automatisation du suivi qualité et animation d’équipes

La deuxième étape s’est focalisée sur l’automatisation du suivi des pièces non conformes (PNC). Dès qu’un défaut est détecté, l’opératrice vient renseigner sur sa tablette la référence qui a un défaut, et elle peut aussi caractériser le type de défaut selon la nomenclature proposée. Le technicien qualité visualise l’alerte sur son écran de supervision, et en cliquant sur la référence, peut déjà avoir un premier retour sur la nature des problèmes. Il peut ainsi décider d’intervenir ou non, selon que le défaut concerne une carte électronique à 70 euros ou un emballage à 10 centimes. Cela lui permet de prioriser ses actions et de stopper les défauts au plus tôt. Finies les feuilles de contrôle qualité.

La consolidation automatique des données qualité permet à tout moment de visualiser le taux de défaut par type de produit et par poste, ainsi que la distribution des défauts par catégorie, et d’adopter les actions correctives. Résultat : une baisse de 42 % de la non qualité.

Cette deuxième étape a aussi abouti à la numérisation des animations d’équipe dans le cadre de la méthode Lean (points 5 minutes, 15 minutes, etc.) qui se font désormais debout à côté de l’écran tactile où se déversent les données du MES mises en forme. Ces écrans sont également consultables à distance si les responsables sont en télétravail ou en déplacement.

Troisième groupe de sujets traités : maintenance, planification et gestion numérique des approvisionnements sur poste

Maintenance. Puisque, grâce à la numérisation, les temps d’utilisation des machines sont désormais connus, les interventions de maintenance peuvent être ajustées sur les temps d’utilisation réels des machines (plus une machine a été utilisée, plus elle a des chances de tomber en panne), et non plus sur la base d’une fréquence théorique (par exemple, tous les 6 mois). Il ne s’agit cependant pas encore de maintenance prédictive, mais d’une amélioration de la maintenance préventive. Le système est aussi utilisé pour visualiser les actions de maintenance à réaliser, ainsi que l’historique des interventions, ce qui réduit le temps d’intervention. Résultat sur ce poste : une réduction de 30 % des temps de maintenance, qui participe à l’amélioration du TRS.

Planification. L’ordonnancement de l’usine est entièrement numérisé, ce qui permet d’optimiser le temps de préparation du planning de production, mais aussi d’effectuer l’ordonnancement à distance. Sur ce point, une couche d’IA est utilisée qui permet à l’algorithme de faire une première proposition d’ordonnancement en fonction de multiples paramètres, puis le responsable de production intervient pour procéder aux ajustements et ajouter sa plus-value.

Gestion numérique de l’approvisionnement des composants sur les postes. Cette brique permet d’aligner le flux physique des composants entre le magasin, le picking et les lignes de production, avec le flux d’information en temps réel, ce qui permet des réapprovisionnements automatisés aux différentes étapes ainsi que la génération automatique des commandes de composants.

Prochaine étape : Intelligent Factory

Pour Olivier Maho, la prochaine étape consiste à ouvrir le système à des données extérieures à l’usine en provenance des fournisseurs et des clients. L’objectif final est de maîtriser la supply chain de bout en bout, en de « tracer » les composants en provenance des fournisseurs, puis le produit fini jusqu’à sa livraison chez le client. Olivier Maho se donne à nouveau trois ans pour y parvenir. Les produits Somfy étant eux-mêmes des produits connectés (domotique), il est aussi envisageable à terme de collecter les données de vie et d’usage des produits eux-mêmes, une fois installés chez les clients finaux, à condition de respecter le RGDP. Mais cette page reste encore à écrire.

Impacts et bénéfices

Les impacts du projet peuvent se mesurer à l’aune de la performance du site (TRS), de la satisfaction client (réduction des non conformités) et de la rentabilité du site.

Impacts et bénéfices du projet

Source : Olivier Maho, Somfy

Mais au-delà des seuls impacts directs et attendus, Olivier Maho met l’accent sur de nombreux bénéfices secondaires.

La simplification des processus, le zéro papier, rendent le travail plus agréable et satisfaisant. Les personnels intérimaires deviennent plus faciles à intégrer sans impact sur la performance immédiate, car la prise en main des interfaces est très intuitive. Les salariés passent plus de temps à analyser les situations, et moins de temps à des tâches fastidieuses et inintéressantes comme les saisies. Et tout le monde devient plus autonome et proactif. Cela insuffle un esprit général d’amélioration continue et d’innovation où chacun vient avec des idées et des sujets à traiter par le numérique.

Les relations deviennent plus fluides et plus collaboratives, car les personnes discutent sur la base de faits et de données, plutôt qu’avec des impressions subjectives et des ressentis ou en se renvoyant la balle entre services.

Enfin, l’attractivité du site de Rumilly s’est fortement renforcée sur le bassin d’emploi, car le numérique rend l’usine plus « fun ». L’image globale du groupe Somfy en bénéficie aussi via la labellisation « vitrine de l’industrie du futur ».

Cette expérience reste pour le moment isolée au sein du groupe et limitée au site de Rumilly.

Efficacité opérationnelle des usines : le défi du passage à l’échelle

Ce qu’Olivier Maho a réalisé à l’échelle d’une usine, il faut maintenant l’imaginer porté à l’échelle d’un groupe disposant d’un grand nombre d’usines à travers le monde.

De tels projets ne sont guère fréquents. Même dans les grands groupes, on procède plutôt par la transformation d’au maximum quelques usines dans le monde qui deviennent les « vitrines du groupe ». D’une part, parce que ce sont des projets coûteux. D’autre part, parce qu’un groupe mondialisé recouvre fréquemment une grande hétérogénéité de situations industrielles. S’il existe souvent une logique centralisée et globale qui anime les dirigeants, il est rare que soit appliqué un moule uniforme à toutes les usines. Une assez grande autonomie et latitude sont laissées aux directeurs d’usine en fonction des besoins réels de chaque site industriel.

L’avis de l’expert − Alexandre Pinot, consultant associé « transformation digitale » pour IBM

Pourquoi la transformation digitale des sites industriels d’un groupe se fait-elle rarement à l’échelle mondiale, mais plutôt au cas par cas ?

Il peut y avoir une vision mondiale, mais rarement un passage à l’échelle mondial de ces projets. Cela s’explique par plusieurs raisons :

1. Les activités : dans beaucoup de grands groupes, les usines et les métiers ne sont pas au même niveau d’automatisation et ne produisent pas exactement les mêmes biens. S’il est courant de dire que les groupes industriels doivent être compétitifs et réactifs, le degré d’exigence diverge quand même selon le type d’activités. En conséquence, il y a des cas d’usage qui seront pertinents sur certaines activités, et pas sur d’autres. Évaluer les vrais besoins des sites et des situations est un pré-requis.

2. La règlementation : la règlementation du travail et les exigences de sécurité varient d’un pays à l’autre. Dans certains pays comme la France ou l’Allemagne, les exigences à l’égard de la sécurité des travailleurs sont fortes, et on va donc créer des équipements connectés adaptés. Dans d’autres pays malheureusement, la sécurité des travailleurs n’est guère une préoccupation et les entreprises ne vont donc pas investir sur de tels équipements.

3. Le coût de la main d’œuvre : la décision d’investir sur l’automatisation de certains processus complexes dépend beaucoup du coût du travail. Si la main d’œuvre est bon marché, le ROI de ces projets est moindre que dans un pays comme la France. En revanche, dans nos pays, cette modernisation peut permettre de maintenir localement l’activité productive.

4. Infrastructures : d’un pays à l’autre, le tissu économique, la connectivité varient beaucoup. Un capteur très sophistiqué ne pourra pas être installé dans certains pays.

Porter à l’échelle de tout un groupe la modernisation des usines, c’est pourtant le défi qu’a su relever le groupe L’Oréal, à un rythme assez impressionnant.

Business Case n°2 – L’Oréal – Renforcer la performance industrielle des sites de production

Fiche d’identité

• Activité : leader mondial de la cosmétique

• Siège social : Clichy (France)

• 86 000 collaborateurs, dont 18 000 dédiés aux opérations

• Slogan : Parce que nous le valons bien (depuis 2011)

L’Oréal est un industriel de la beauté. Si tout le monde connaît les marques de luxe, grand public, cosmétique active et professionnelles du leader mondial de la cosmétique, beaucoup ignorent que le groupe est aussi une grande entreprise manufacturière qui produit 7 milliards de produits par an, soit 20 millions de produits chaque jour, dans 39 usines réparties à travers le monde.

Sous l’impulsion de Jean-Paul Agon, avec l’appui de Lubomira Rochet, CDO nommée en 2014, et Barbara Lavernos, Executive Vice-President Chief Technology and Operations Officer, L’Oréal a entrepris une transformation digitale de grande ampleur qui concerne tous les métiers et tous les pays de l’entreprise. Jean-Paul Agon a coutume de dire que « le numérique, ce n’est pas la cerise sur le gâteau, c’est le gâteau, le nouveau gâteau. »

Les Opérations de L’Oréal – qui ont la responsabilité de l’ensemble de la chaîne de valeur, depuis la conception packaging, le développement produits, la production (c’est-à-dire les usines) et la distribution – sont également concernées par cette transformation. Les innovations organisationnelles et technologiques ont vocation à être menées en mode Test&Learn (avec son corollaire « fail fast »), c’est-à-dire sur de petits périmètres et des cas d’usage bien identifiés, et si les résultats sont probants, à être déployées ensuite avec rapidité à l’échelle internationale.

L’évolution de l’outil industriel commence en 2017 via un partenariat mondial avec IBM. Parmi les usines de L’Oréal, 35 fonctionnent déjà, depuis plus de dix ans, avec un core model ERP/SAP commun, parfaitement maîtrisé. C’est parmi celles-ci que seront choisies les usines pilotes pour déployer les premiers cas d’usage.

Cas d’usage : les lignes de production connectées

Les lignes de production peuvent subir de multiples arrêts : des temps d’attente, des micro-arrêts, des pertes de cadences ou encore des pannes. En cumul, cela peut représenter une perte de performance de 5 à 30 %. Pour pouvoir réduire ces arrêts et améliorer la performance, encore faut-il comprendre ce qui se passe : quelle est la nature de ces arrêts, et quelles en sont les causes. Cela nécessite de « faire parler » les machines. Or, une remplisseuse, un palettiseur, une encartonneuse, sont pilotés par des automates industriels qui n’ont pas été conçus pour fournir de la donnée.

La première étape de ce type de projet consiste donc à aller capter la donnée contenue dans les machines, et donc à connecter deux catégories de technologies − les automatismes industriels (OT) et les systèmes d’informations (IT) − et à faire travailler ensemble automaticiens et informaticiens qui n’ont pas toujours la même culture, ni les mêmes savoir-faire, ni le même langage.

Une fois cette donnée captée, il faut la restituer aux opérateurs via des interfaces adaptées. Ce premier niveau d’information en temps réel permet aux opérateurs une meilleure autonomie et rapidité dans les prises de décisions de pilotage de la ligne, et d’adopter de nombreuses mesures correctrices pour optimiser les opérations sur la base de faits et de chiffres. La consolidation des données permet ensuite d’enregistrer un historique des incidents et de visualiser les causes les plus fréquentes (par ex. 80 % des arrêts sur cette machine sont dus à…).

Cela permet de s’attaquer aux problèmes les plus récurrents : changer les réglages, améliorer les procédures, sensibiliser les opérateurs à certaines mesures, etc. Enfin, la troisième étape consiste à nourrir un système de machine learning (en l’occurrence la plateforme Watson IoT) avec les données ainsi recueillies. L’algorithme va alors procéder à des liens et à des corrélations entre les données. C’est à ce stade que l’on commence vraiment à apprendre des choses nouvelles, puisque le système produit des recommandations qui pourront ensuite être testées : par exemple, conseiller sur de nouvelles valeurs de réglage des machines adaptées aux composants et aux conditions de travail.

Cas d’usage : l’opérateur augmenté et les changements de séries

Comme de nombreux groupes de grande consommation, L’Oréal doit faire face à des comportements de consommation qui changent vite. Le groupe sert plus d’un milliard de consommateurs autour du globe qui exigent à la fois une grande variété et une haute qualité de produits. La diversité des références s’agrandit. Cela entraîne une réduction de la taille des lots à produire, pouvant aller jusqu’au lot unitaire : la personnalisation à l’unité est une promesse très attractive pour les cosmétiques (une crème adaptée à ma peau, une ombre à paupière assortie à l’exacte couleur de mes yeux, une coloration bien adaptée à ma couleur d’origine et à la nature de mes cheveux8), rendue possible par le développement des commandes en ligne (e-commerce).

Cette réduction de la taille des lots augmente le nombre de changements de séries sur les lignes de production. Les tâches liées à ces changements sont parmi les plus complexes pour les opérateurs. Le but est de diminuer le temps de passage d’une série à une autre, en obtenant des changements d’outils rapides ou des réglages instantanés, et d’arriver plus vite à un produit « bon du premier coup » (ou jidoka). Cette assurance de la qualité par une prescription des tâches relatives au changement, permet également de réduire les consommations de matières, d’énergie et de travail, et a donc un impact direct sur les coûts. Si les temps de changement de série deviennent plus courts, les coûts diminuent, le TRS s’améliore et l’on peut dès lors envisager des lots de plus en plus petits tout en garantissant une maîtrise parfaite de la qualité.

Le projet mené chez L’Oréal a consisté à apporter une solution numérique aux opérateurs, afin de faciliter les changements de produits, plus rapidement et de manière plus fluide, en limitant les déplacements le long de la ligne.

La solution retenue est un smartphone doté d’une app, qui permet un fonctionnement aisé en mobilité le long de la ligne. Lors d’un changement de série, le MES envoie l’information à l’opérateur et l’application affiche automatiquement la meilleure procédure à suivre, ainsi qu’au besoin, des photos couleur pour visualiser la procédure et des tutoriels vidéo. L’opérateur renseigne les étapes de la procédure avec de simples clics ou scans, informations qui remontent dans le MES, puis dans le cloud. L’analyse de cette data pourra servir à améliorer encore la procédure.

Matériel et interfaces ont été conçus avec les opérateurs lors de séances de design thinking et améliorées par itération agile, ce qui en a grandement facilité l’appropriation. En 2020, ces nouvelles façons de travailler ont déjà été déployées dans la majorité des usines, et les indicateurs (TRS, volumes de production, coûts de non qualité) se sont largement améliorés.

À mesure que les cas d’usage sont validés par L’Oréal puis déployés, de nouveaux entrent dans le jeu. La numérisation de l’outil de production est un travail au long cours.

D’après : https://www.loreal.fr/groupe/loreal-et-la-beautytech

https://www.lesechos-digital.fr/29/club-les-echos-digital-avec-jean-paul-agon-et-lubomira- rochet

http://www.mbadmb.com/loreal-la-transformation-du-leader-mondial-de-la-cosmetique- en-pionnier-de-la-beautytech/

Think Summit Paris 2019 : Table ronde « Plateformes et transformation ». L’Oréal, Barbara Lavernos, Executive Vice-President Chief Technology and Operations Officer https://www. youtube.com/watch?v=utJP5FAS5qs&ab_channel=IBMFrance

Think Summit Paris 2019: Talk «IOT et IA dans l’industrie». L’Oréal, François Ly, Domain manager Operations 4.0 https://www.youtube.com/watch?v=Im4xGcKvT5o&ab_ channel=IBMFrance

L’Oréal + IBM : Un relooking pour l’Industrie 4.0 https://mediacenter.ibm.com/media/L% 27Or%C3%A9al+%2B+IBM+A+Un+relooking+pour+l%27Industrie+4.0/1_l18i2pdm

Détection visuelle, automatisation et opérateur « augmenté »

Avez-vous déjà vu une trieuse-calibreuse de fruits et légumes en action ? Quand la machine est filmée, il est quasiment impossible de saisir à l’œil le moment de l’éjection des produits non conformes tant la cadence est rapide. Pendant longtemps, les opérations de tri reposaient essentiellement sur la vision et la vitesse manuelle des collaborateurs le long d’un convoyeur. Aujourd’hui, la plupart des trieuses sont basées sur la reconnaissance optique appuyée sur des logiciels qui permettent de définir les critères de calibrage désirés, les couleurs, etc. La détection visuelle des défauts s’opère via des caméras à haute résolution (les capteurs), à grand angle de vision et sous un éclairage à haute intensité lumineuse. Les images viennent nourrir un système à base d’intelligence artificielle qui renforce au fur et à mesure sa capacité de reconnaissance visuelle pour améliorer la qualité du tri et diminuer le nombre d’erreurs.

De la même manière, de nombreux processus de précision qui reposaient intégralement sur les compétences humaines peuvent aujourd’hui être automatisés ou assistés par le digital : par exemple, la détection des défauts des peaux dans la confection des sacs de luxe ou encore l’appréciation de la gomme des pneus. On parle parfois d’opérateur « augmenté ».

Comme nous le discuterons au chapitre 5, cette notion d’opérateur « augmenté » par le numérique est assez ambiguë : parfois l’opérateur peut être tout simplement remplacé (cas des anciens trieurs de fruits et légumes), parfois ses compétences sont assistées par le numérique (capacités de détection renforcées comme dans le cas des grutiers ci-dessous), parfois le processus est effectivement automatisé et l’opérateur devient un contrôleur machines/processus − il vérifie que le processus se déroule conformément au protocole et sans anomalies −, enfin le processus peut être partiellement automatisé mais le niveau de qualité requis sollicite des compétences humaines en de nombreux points de contrôle. Dans de nombreux secteurs où la qualité prime (luxe, horlogerie, par exemple), le savoir-faire humain patiemment développé par une longue expérience reste indispensable pour détecter les défauts.

Business Case n°3 – L’intelligence artificielle au service des opérateurs sur les sites de recyclage

Un groupe français, opérateur de services aux entreprises et à l’environnement, spécialisé dans le recyclage, la valorisation des biens en fin de vie et la gestion des déchets industriels et ménagers, a exploré différents moyens de moderniser et valoriser ses sites de recyclage de métaux.

Problématique

L’activité de recyclage des métaux débute invariablement par le tri de ceux-ci : les produits ou éléments métalliques (déchets d’équipements électriques et électroniques, véhicules hors d’usage, éléments de construction, machines industrielles, vélos, trottinettes… ) sont recueillis en tas et peuvent contenir un grand nombre de pièces différentes, susceptibles de poser problème au moment du passage dans le broyeur : bouteille de gaz, barre de fer trop longue, élément en métal trop épais, bidons contenant des produits chimiques… Les risques sont élevés en cas de passage d’objets dits « imbroyables » : explosions, pollution, blocage ou destruction du système de broyage, etc.

Dès lors, le principal enjeu lors des opérations de tri, réalisées par des conducteurs de pelles mobiles et de grues, est de repérer les « imbroyables » pour les isoler. Une bouteille de gaz dans le broyeur et c’est tout le site qui risque de prendre feu. Dans ces conditions, le grutier a un rôle clé dans la performance et la sécurité d’un site de recyclage. Il doit savoir manipuler avec une extrême précision les griffes de sa machine pour sélectionner, extraire et isoler les objets potentiellement inadaptés au broyage ou dangereux. Sa vigilance et la précision de son geste sont déterminantes dans la bonne marche des opérations. Ce savoir-faire très technique s’acquiert avec l’expérience qui est au moins aussi importante que la qualification. Il est donc toujours difficile de recruter des grutiers expérimentés.

Quels objectifs ?

La réduction du nombre des imbroyables mal orientés, a été diagnostiquée par la direction comme le sujet n°1 à résoudre, pour des raisons à la fois économiques et de sécurité. Si les grutiers ont développé un sens aiguisé de l’observation, leur capacité à identifier les objets peut être altérée par la fatigue, les intempéries ou tout autre facteur gênant pour l’œil humain. En reconnaissant les objets dangereux, l’intelligence artificielle pourrait accompagner le travail du grutier et lui signaler les objets à isoler. Si les grutiers travaillent de pair avec les technologies, alors c’est autant d’accidents, de fermetures de sites et de coûts supplémentaires qui sont évités. Suite à la consultation d’opérateurs sur le terrain, le projet prend forme : la mise en place d’un système de caméras connectées sur les sites de recyclage visant à aider l’opérateur dans son quotidien.

Comment ça marche ?

Le projet a d’abord été expérimenté au sein d’un site de recyclage, choisi pour son taux relativement élevé d’imbroyables. Des caméras très robustes, capables de supporter des chocs et des conditions météorologiques extrêmes, ont été installées sur les grues de façon à pouvoir visualiser la montagne de ferrailles présente sur le site. Les images collectées sont ensuite transmises en temps réel par un système de wifi renforcé à un service d’intelligence artificielle qui est hébergé localement sur un serveur du site (on parle ici de « edge computing ») et également relié à un cloud.

Le principe a d’abord consisté à apprendre au système à identifier le maximum d’objets susceptibles d’être des imbroyables. Le système de Machine Learning, s’est ainsi nourri de l’ensemble des images captées sur le site d’expérimentation, pour apprendre à détecter les imbroyables. Plus un système de Machine Learning reçoit de données, plus il apprend et plus il gagne en précision. L’algorithme d’apprentissage a été perfectionné jusqu’à obtenir un taux satisfaisant de reconnaissance qui peut toutefois varier en fonction de la météorologie, de la luminosité ou encore de l’état de propreté des caméras. Le système n’est donc pas infaillible mais il apporte une contribution à la vigilance de l’opérateur et, dans certains cas, lui permet de repasser sur une zone lorsqu’il y a un doute détecté par le système.

Le système de edge computing analyse en temps réel les images de toutes les caméras installées et transmet ensuite des alertes de détection des imbroyables sur une tablette présente dans la cabine du grutier et sur le poste du superviseur du site. Les images détectées ne sont accessibles qu’aux utilisateurs du site. La confidentialité des modes opératoires sur le site est ainsi préservée.

Accompagnement des opérateurs de terrain

Ce projet d’identification des imbroyables par caméra a d’abord suscité des interrogations chez les salariés du site d’expérimentation. Ils avaient en particulier deux sources d’inquiétude : la première, d’être progressivement remplacés par des robots et la seconde, d’être mis sous surveillance par des caméras. Un travail d’accompagnement et de démonstration a donc été réalisé pour gagner la confiance des salariés : ces nouveaux outils n’ont pas vocation à se substituer au grutier dont les tâches sont très complexes mais plutôt à faciliter son action et à l’aider à maintenir sa vigilance. La tablette l’accompagne, en effet, dans la lourde tâche que constitue la détection des imbroyables et les opérateurs ont pu observer que le système ne servait pas à d’autres fins que celles de les aider. À l’instar des systèmes d’alerte à la vigilance disponibles dans certains véhicules, l’intelligence artificielle vient ici contribuer au repérage des objets mais ne pourra pas remplacer l’œil (et l’oreille) de l’opérateur.

Résultats et déploiement

Une fois le dispositif mis au point, il a contribué à une diminution des erreurs commises dans l’identification des imbroyables. Les conclusions en termes de retour sur investissement ne peuvent pas être encore établies mais la direction est confiante sur l’effet d’échelle dans un déploiement prévu sur l’année 2021. La réduction des erreurs sur imbroyables relève non seulement de l’efficience économique mais surtout, elle contribuera à l’amélioration de la sécurité des personnes et des équipements industriels.

Maintenance

Un champ d’application très important de l’IIoT concerne la maintenance, et plus spécifiquement la capacité d’une entreprise à passer d’une maintenance préventive à une maintenance prédictive.

Pour toutes les entreprises qui vendent ou utilisent des machines industrielles, la maintenance est un poste de coûts qui touche le cœur des opérations industrielles. Une machine en panne, c’est une production qui s’arrête, des temps morts, des pertes, des délais, une qualité de service dégradée, des clients insatisfaits. Pour éviter les pannes, la plupart des entreprises font de la maintenance préventive, c’est-à-dire qu’elles immobilisent périodiquement les machines pour les inspecter et changer préventivement certaines pièces usées, selon des modèles statistiques donnés par les fournisseurs ou des coefficients « maison ». Quand une entreprise progresse dans sa connaissance du taux d’utilisation de ses machines, elle peut commencer à organiser une maintenance préventive plus efficace et ciblée, affiner ses propres statistiques, et donc immobiliser moins souvent et moins longtemps ses machines. Mais quand elle devient capable d’anticiper les pannes grâce à des alertes lui indiquant la probabilité d’une défaillance imminente, alors elle passe à la maintenance prédictive : elle n’intervient plus qu’à bon escient et peut ainsi faire baisser les coûts directs et indirects du poste maintenance. Tel est le principe.

Un exemple : Évolution de la maintenance à la SNCF

La SNCF s’appuie de plus en plus sur l’IoT et l’IA pour faire circuler ses trains et prévenir les défaillances. Mais comment vérifier l’état des 50 000 km de voies et des 15 000 trains qui circulent quotidiennement en France ? La majorité des vérifications se font encore par des sondages des agents sur le terrain.