Le design du travail en action. Transformation des usines et implication des travailleurs

Préface

Qui perçoit le mieux les dysfonctionnements d’une machine ?

Qui ressent le mieux le manque d’ergonomie d’un poste de travail ?

Qui voit les instabilités, le manque de fiabilité, les inefficacités d’un procédé ?

Qui, par l’expérience acquise, peut anticiper des anomalies à venir ?

Qui ? Si ce n’est celle ou celui qui conduit la machine !

Et ce type de questions, on peut se les poser pour tout équipement professionnel : une machine, des outils, un logiciel, l’aménagement des bureaux…

Dans le monde industriel, oui, il est évident qu’il faut savoir impliquer les opérateurs dans la conception et l’évolution des équipements industriels, de leur poste de travail et de leurs outils !

Pour autant, ce qui paraît évident, en théorie, l’est peut-être un peu moins lorsqu’il s’agit de la pratique. En effet, le manque de structure, de processus, de temps, de détermination ou encore d’humilité de la part des décideurs sont autant de raisons qui peuvent entraver cette implication. Il est donc nécessaire de s’organiser : organiser en « système » ces pratiques d’écoute, de consultation et d’expérimentation.

Autrement dit, ces pratiques doivent devenir un mode de fonctionnement inscrit dans l’organisation du travail, que ce soit pour l’évolution ou la création de nouveaux outils de travail, puis devenir une habitude, une évidence dans la culture d’entreprise.

Le bénéfice de cette approche est au moins double.

Le premier bénéfice est de concourir à la qualité de vie au travail des utilisateurs des équipements, en leur permettant de contribuer à la résolution de problèmes, la suppression d’irritants et aussi à une meilleure ergonomie.

Le second concerne directement l’excellence opérationnelle, une très belle ambition qui permet de faire un saut quantitatif en performance, que ce soit en ergonomie, sécurité, qualité, productivité, flexibilité… Cette recherche de l’excellence opérationnelle doit pouvoir s’appuyer sur l’excellence du design des postes de travail.

C’est pourquoi le sujet traité dans ce livre me semble absolument fondamental pour répondre à l’ambition d’obtenir à la fois le bien-être des personnes au travail et la performance de l’entreprise.

Chez Michelin, nous avons généralisé ces approches d’écoute, de réflexion partagée avec les utilisateurs des équipements industriels. Nous avons systématiquement obtenu des résultats remarquables, souvent des résultats « qui décalent les asymptotes » sur l’ensemble des performances attendues !

Pour y parvenir, nous pouvons utiliser des méthodes très classiques et simples (simogramme, flowchart, prototypage, maquette…) aussi bien que les technologies les plus modernes (lunettes 3D et maquettes virtuelles 3D en taille réelle…).

Cependant, quelle que soit la technologie, nous agissons selon quelques convictions fondamentales.

« Ceux qui font » ont à cœur de bien faire et, s’ils ne font pas comme attendu, alors regardons d’abord comment les aider en redéfinissant avec eux leur processus de travail.

« Ceux qui font » en savent plus qu’on ne le croit, alors prenons le temps de les écouter. Organisons cette écoute au quotidien et apprécions leurs idées.

Écoutons, écoutons avec authenticité, écoutons avec le cœur !

Je vous souhaite une excellente lecture de cette remarquable synthèse et analyse portant sur l’évolution des méthodes de travail industrielles, qui regorge d’expériences riches et passionnantes.

Jean-Christophe Guérin Directeur manufacturing de Michelin

Remerciements

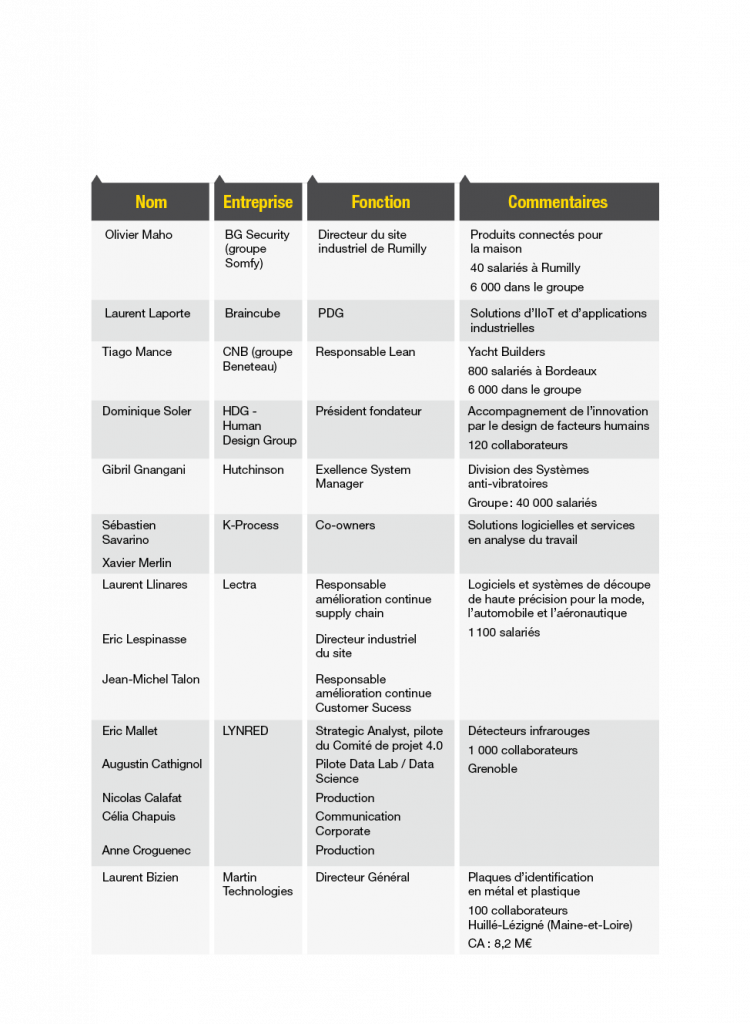

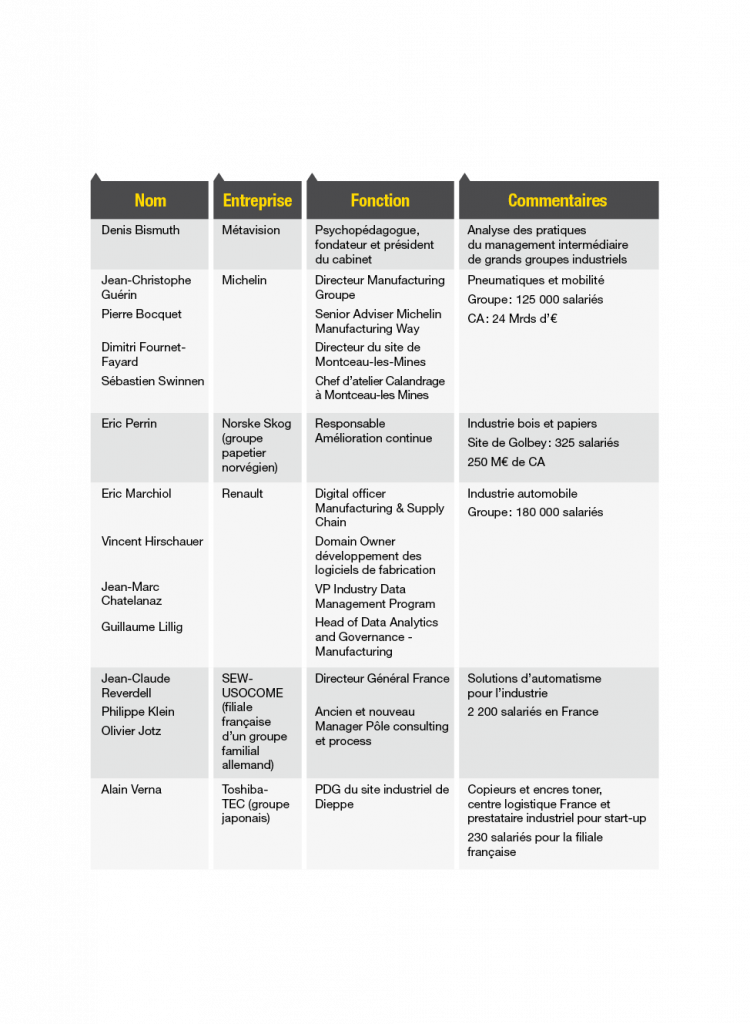

Nous remercions très chaleureusement toutes les personnes et les entreprises citées en Annexe qui nous ont apporté leur témoignage et sans lesquelles ce livre n’existerait pas.

Un grand merci à Pierre-Marie Gaillot du Cetim pour son soutien et son aide dans les mises en relation.

De nombreuses autres personnes ont également nourri notre réflexion. Qu’elles en soient ici remerciées : Stéphane Roquet, Isokan Formation ; Franck Vermet, Safran Seats ; Thomas Neveu et Baptiste Gendron, Yelhow (ex Daher Software) ; David Machenaud, OPEO ; Octave Lapeyronnie et François Déchelette, Fabriq ; Frédéric Rosello, Ideatech ; David Clech, Akka Technologie ; Jean-Louis Fréchin, NoDesign ; Pascal Laurin, Bosch Rexroth ; Janick Villaneau, Scalian ; Betrand Felix et Valérie Bonnier, Volvo Trucks et La Ruche Industrielle ; Bruno Bouygues, GYS ; Loïc Gauthier, EOZ ; Frédéric Stoll, École POP ; Romain Serratore, Pellenc ; Francis Kopp, Lenze ; Pierre Magrangeas, Onogone ; Stéphane Raynaud, GFI ; Frédéric Goutaudier, Staubli ; François Duquesne, La Normandise ; Garrick Cabour, Polytechnique Montréal ; Damien Marc, JPB Système.

Enfin, nous voudrions adresser un remerciement spécial à Léonard Quérelle d’Ergonomie et Conception, qui nous a fait découvrir les travaux de Philippe Lorino sur la philosophie pragmatiste, ainsi qu’à Philippe Lorino lui-même pour avoir inspiré une partie de cet ouvrage et accepté d’y apporter sa postface.

« Je me souviens d’une visite officielle au cours de laquelle sept agents de production entre 20 et 27 ans ont expliqué sans timidité comment ils avaient installé une machine de très grande valeur, plusieurs dizaines de millions d’euros, dans un atelier, en autonomie totale. Tel s’était occupé de la qualité, l’autre de la production, le troisième de la formation, un autre de la chaîne d’approvisionnement… À côté d’eux, le chef d’atelier ne disait rien, souriait… »

Jean-Dominique Senard, La Croix, 12 décembre 2020.

Introduction

Cette Note fait suite à un premier ouvrage intitulé Organisation et compétences dans l’usine du futur1, paru en 2019 sous l’égide de la Chaire Futurs de l’industrie et du travail de Mines Paris PSL et de La Fabrique de l’industrie. Ce premier travail a consisté à investiguer si et comment les technologies dites de l’industrie du futur impactent l’organisation du travail et la gestion des compétences dans les usines.

Ce travail a mis en lumière plusieurs conclusions.

Premièrement, sur le plan des compétences, l’introduction des nouvelles technologies dans les ateliers suppose moins de procéder à l’embauche de profils qui seraient radicalement différents ou nouveaux que de travailler différemment avec les profils actuels :

• agir sur la transformation de l’état d’esprit (susciter la curiosité, développer l’amélioration continue, solliciter les personnels via des méthodes de management plus participatives, provoquer les collaborations et le décloisonnement, diffuser les méthodes agiles) ;

• concevoir différemment les formations (plus courtes, par les pairs sur le lieu de travail, avec les fournisseurs de technologies, avec l’appui de la réalité virtuelle ou augmentée, etc.) ;

• recruter en tenant compte de la capacité et de l’envie d’apprendre, du potentiel et du hors CV ;

• faire évoluer les personnes et les accompagner en fonction des goûts et des intérêts qui s’expriment, notamment pour les nouvelles technologies.

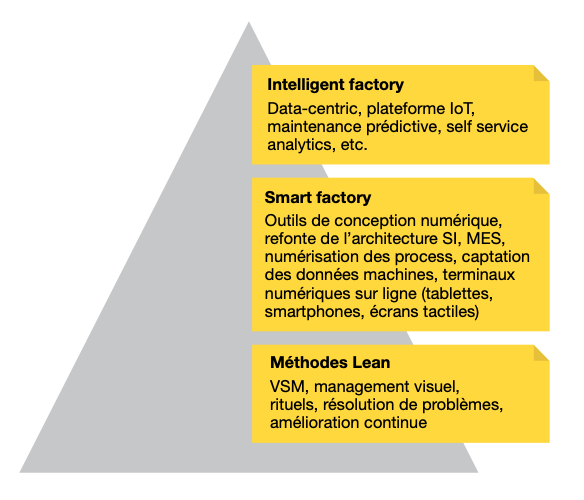

Deuxièmement, l’intégration de nouvelles technologies dans les usines et leur appropriation par les collaborateurs se font d’autant plus aisément que certains prérequis sont déjà présents dans l’organisation :

• un certain niveau d’autonomie des personnels de production ;

• une application bien comprise des méthodes de lean management – en particulier les ateliers d’amélioration continue et les rituels de management ;

• la confiance entre la direction, le management et les salariés. Celle-ci se construit tout au long du déploiement de l’autonomie, du lean, puis de l’introduction des technologies.

Ces constats ont été formalisés dans le Modèle CALT, dont les quatre briques (Confiance, Autonomie, Lean et Technologie) sont analysées dans l’ouvrage.

Enfin, l’analyse a fait émerger le concept de design du travail®2. Celui-ci est défini comme la capacité d’une organisation à prendre en compte les personnels, en particulier les opérateurs et les techniciens de production, et à les faire participer à la conception ou à l’organisation de leur propre travail, de la même manière qu’un utilisateur/client est associé au développement et à la mise au point de logiciels et d’interfaces dans le monde numérique. D’autres sources parlent d’« expérience travailleur »3 sur le modèle de l’expérience utilisateur (User eXperience, ou UX).

L’intérêt exprimé par nos lecteurs pour ce concept nous a conduits à approfondir et documenter davantage les expériences en cours dans les usines, qui pourraient s’apparenter ou révéler des intentions de design du travail. Tel est l’objet de ce second volet : le design du travail en action.

Source : Pellerin et Cahier (2019).

Retour sur le design du travail

Étymologiquement, « design » dérive du latin designare, « marquer d’un signe, dessiner, indiquer ». À la Renaissance, le disegno italien est l’un des concepts majeurs de la théorie de l’art : il signifie à la fois dessin (la représentation) et projet (l’intention, le plan). En France, le terme deviendra desseing avec le double sens d’idée et de forme. Mais ce double sens va se disjoindre rapidement pour donner deux champs sémantiques distincts, celui du dessin (la pratique) et du dessein (l’idée), marquant une rupture fondamentale entre la conception et l’exécution, qui n’est pas sans rappeler la dualité matière-esprit de Descartes. Lorsque l’anglais s’empare du terme, il agrège à nouveau les deux sens : to design signifie à la fois dessiner (réaliser) et concevoir en fonction d’un dessein, d’une intention. Le terme revient alors en France sous la forme actuelle de design.

Le terme de design ne va cesser de s’enrichir au fil du temps dans une perspective toujours plus holistique. Pour la création de produits à l’ère numérique, la « pensée design », développée par exemple au MIT Media Lab, intègre l’observation des usages, l’expérience de l’utilisateur et la valeur pour le client dès la phase de conception. On conçoit désormais le produit, le service ou l’interface pour et avec l’utilisateur final.

Dans les coulisses de la production industrielle, en revanche, la conception de produits a longtemps été une affaire d’ingénieurs (le bureau d’études), disjointe de sa fabrication (l’atelier) par des cloisons organisationnelles, hiérarchiques et psychologiques très étanches. De même, l’organisation scientifique du travail (OST) a marqué une séparation nette entre ceux qui conçoivent le travail de production (les ingénieurs du bureau des méthodes) et ceux qui le réalisent (les ouvriers). Frederick W. Taylor écrivait ainsi : « Toute forme de travail cérébral devrait être éliminée de l’atelier et recentrée au sein du département conception et planification »4. La combinaison des termes design et travail devient alors un antidote contre le taylorisme. L’expression réunifie dans un même mouvement la pensée et l’action.

Appliquer la pensée design au travail conduit à un déplacement de la notion de client. Le client de la conception et de l’orga- nisation du travail, ce n’est pas que le client final, mais aussi celui qui réalise le travail. Cela implique que l’objet de l’organisation ne peut pas être la seule satisfaction du client final (usages, coût, qualité, délai), mais que ceux qui réalisent le produit ou le service doivent aussi être considérés comme clients de la conception du travail de production. Dans le même esprit, certains travaux parlent aussi d’une éthique du care, plaçant en symétrie le care pour le client et le care pour le collaborateur, l’un rétroagissant in fine sur l’autre5.

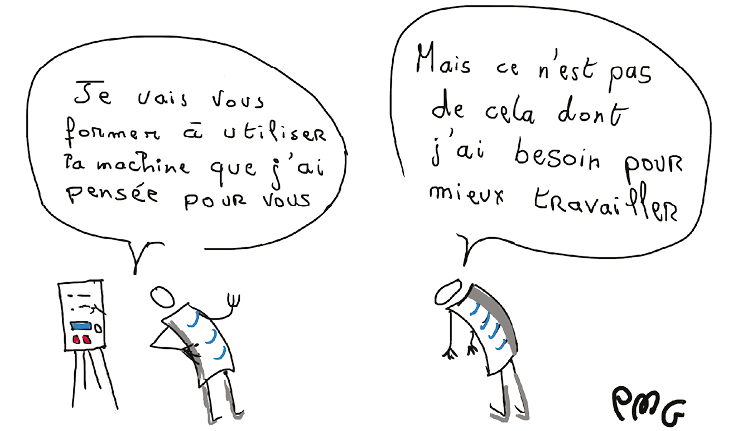

C’est qui le client !

© Pierre-Marie Gaillot, CETIM.

Mais le concept de design du travail va plus loin. Il ne s’agit pas seulement de concevoir, positivement mais de façon hétéronome, le travail pour le client « travailleur » (par exemple, sous l’angle du respect des normes de santé ou de sécurité au travail), mais aussi de le faire participer directement à la construction de son propre travail (contenu, outils, rythmes, lieux) : d’une part, intégrer à la conception du travail l’expérience et les capacités de ceux qui le réalisent, avec leur concours, et d’autre part, assurer une bonne appropriation (compré- hension, adaptation, utilisation, enrichissement) des outils et méthodes qui sont mis à la disposition des travailleurs.

On change alors de regard sur la contribution du travailleur, qui cesse d’être une simple utilité concourant au processus productif, mais un sujet pensant, actif et impliqué. Designer le travail, c’est s’intéresser à celui qui travaille, à son métier, au contenu de son travail, à comment il travaille, au sens de son travail et… l’associer à la définition de cet ensemble. Avec le double sens du mot design, il résulte que le design du travail se préoccupe autant des moyens mis en œuvre (le dessin) que de l’intention (le dessein).

Les nouvelles formes de l’autonomie et de la participation au travail

Le design du travail s’intéresse à ce qui fait historiquement le cœur de la prérogative de l’employeur : l’organisation du travail, c’est-à-dire l’ensemble des instructions, ordres, processus, moyens, interactions et règles fixés par l’entreprise au service d’un objectif.

Historiquement, en échange de la protection accordée au travailleur (salaire, emploi et droits qui s’y attachent), l’entreprise requiert sa subordination. Un salarié travaille sous les ordres d’un employeur, il n’est pas là pour donner un avis ou participer aux décisions.

Cette conception ancienne a toutefois subi de nombreux coups de boutoir. La psychologie du travail a montré, par des expériences diverses, que la participation des travailleurs pouvait agir sur leur productivité6. Plus récemment, les impératifs d’agilité et de flexibilité requis dans des contextes de changements technologiques accélérés, de concurrence accrue, d’exigence du client et d’incertitude, ont conduit les entreprises à prendre de plus en plus en compte l’idée que l’autonomie, la réduction des hiérarchies, la créativité des personnes et leur engagement constituaient des facteurs de productivité et des « actifs immatériels » déterminants pour leur succès7. Il semblerait qu’il y ait désormais un quasi- consensus pour affirmer que des modèles d’organisation plus responsabilisants et favorisant l’intensité des échanges entre les salariés (ou high-performance work systems) représentent une dimension importante – mais toujours difficile à évaluer avec précision8 – de l’avantage compétitif des entreprises. Parallèlement, les salariés, toujours plus informés et éduqués, demandent à l’entreprise de satisfaire une partie de leurs aspirations profondes en matière de conditions de travail (horaires, lieux, rémunérations, outils de travail, autonomie, développement des compétences) et de sens au travail, sous peine de choisir d’autres formes d’activité (indépendance, freelancing) ou de se désengager (maladie, absentéisme, refus de promotions, passivité, job out, etc.)9.

Plus il est demandé aux salariés de s’engager dans l’entreprise avec toute leur personnalité, leur intelligence, leur force de proposition, plus il devient difficile de les tenir à l’écart des décisions qui les concernent directement ou indirectement. La conséquence logique de l’engagement demandé par les entre- prises revient à concéder aux travailleurs des formes d’autonomie et de participation à l’organisation du travail et à la vie de l’entreprise, que par ailleurs ils réclament10. Il en résulte que l’autonomie n’est plus seulement revendiquée par les travailleurs ou « clandestine » – car conquise dans les marges du travail prescrit, à l’insu ou avec la complicité du management –, elle est aussi « officielle » et « instrumentale », c’est-à-dire qu’elle s’inscrit dans la stratégie managériale des entreprises, avec une organisation de la participation des salariés à différents niveaux.

Concernant la participation, Michel Sailly11 établit deux classifications : d’une part, la participation directe (interactions managers et salariés, ou dialogue professionnel) versus participation indirecte (via les instances représentatives, ou dialogue social) ; d’autre part, la participation dans le cadre de l’activité quotidienne de travail versus la participation aux projets d’entreprise, organisationnels ou technologiques. En croisant ces deux dimensions, on obtient le tableau suivant.

Les 4 dimensions de la participation

Source : Inspiré de Michel Sailly et al.

Dans cette étude, nous nous concentrons sur la manière dont les entreprises prennent en compte, orchestrent, favorisent (ou non) la participation directe des opérateurs et des techniciens de production à l’organisation de leur travail en lien avec des transformations technologiques ou organisationnelles de l’usine.

Pourquoi s’intéresser particulièrement à cette population ? La question mérite d’être posée car, pour la première fois, en 2020, la population active de la France compte plus de cadres que d’ouvriers (qui sont environ 5 millions)12. Il y a quarante ans, les ouvriers formaient encore le groupe social le plus fourni du pays, devant les employés. Ils étaient alors quatre fois plus nombreux que les cadres et occupaient un tiers des emplois. Si les pentes se poursuivent, leur poids dans l’emploi pourrait encore diminuer de moitié en 2050. Cet état de fait traduit les mutations du travail : la bascule de l’industrie vers les activités de services, la montée du modèle d’activité en autonomie (caractéristique des cadres) versus le travail prescrit et encadré, l’effet de l’automatisation sur les processus de production.

Cette situation, loin de conduire à se désintéresser des populations ouvrières, incite au contraire à y regarder de plus près : primo, l’existence de fortes tensions sur de nombreux métiers d’opérateurs et de techniciens doit inciter les entreprises à « muscler » leur offre en matière d’« expérience travailleur » sous peine d’avoir de plus en plus de mal à recruter et à orienter les jeunes vers un modèle de travail qui, à tort ou à raison, n’attire plus ; deuxio, la montée en compétences des travailleurs de l’usine en voie de numérisation appelle, comme partout ailleurs, une évolution du modèle managérial vers plus d’autonomie et de soutien.

Des technologies qui posent question

La question de la participation des opérateurs et des techniciens de production à la définition de leur propre travail connaît une acuité renforcée à l’occasion de l’introduction des technologies numériques dans les usines. Les rapports entre numérique et travail de production sont, en effet, ambigus.

D’une part, est promue une vision idyllique d’un opérateur « augmenté » par le numérique, avec un travail moins pénible sur le plan physique, plus riche en contenu cognitif, plus diversifié et polyvalent, plus autonome aussi grâce à des outils d’aide à la décision conçus de façon plaisante et ergonomique. D’autre part, il existe un risque non négligeable que les outils numériques qui entrent dans les usines soient conçus, réalisés, standardisés et déployés par des « sachants » numériques, en enserrant les opérateurs dans des modes opératoires entièrement paramétrés par des logiciels. Quelle place resterait-il alors à l’autonomie et à l’amélioration continue partant du terrain ?

Plus encore, les logiciels et les algorithmes peuvent être conçus à partir du savoir-faire et des pratiques des opérateurs qui sont « captés » ou « aspirés » avec des méthodes apparemment modernes et séduisantes (design thinking, captation vidéo, etc.). Une fois ces savoir- faire encapsulés dans les logiciels, il devient alors plus aisé d’insérer sur les postes des personnes à faible qualification, largement « assistées » par le numérique. L’opérateur augmenté, dans le vocabulaire du 4.0, devient alors un opérateur diminué, dont les marges d’autonomie et d’initiative dans le travail tendent à régresser. Plusieurs entreprises ont d’ailleurs témoigné que, par le biais de ces technologies, elles ambitionnent une intégration facilitée et accrue d’intérimaires. L’Organisation scientifique du travail ressurgirait- elle insidieusement, travestie sous les habits lumineux des technologies numériques ? Existe-t-il un risque réel de taylorisme numérique dans les usines ?

Si un cadrage serré des opérations peut être réalisé grâce aux technologies numériques et peut se révéler utile pour intégrer un opérateur qui découvre un poste, il paraît nécessaire de relâcher ces contraintes lorsque l’opérateur monte en expérience, afin que le travail garde son sens et ne devienne pas une routine aussi abêtissante que ne le fut le travail à la chaîne en son temps.

À l’inverse, le numérique peut-il ouvrir aux opérateurs de nouvelles marges de manœuvre, en mettant à leur disposition de nouvelles possibilités d’action et d’acquisition de compétences ?

***

Après avoir esquissé à grands traits la toile de fond sur laquelle s’inscrit le design du travail (chapitre 1 : une approche pragmatiste), nous donnons à voir des situations ou initiatives traduisant des intentions ou des méthodes de design du travail. Nous les avons regroupées en deux catégories.

1. Des cas d’introduction ou de déploiement de technologies

Les cas de cette première catégorie permettent de répondre aux questions suivantes : a) quel outil technologique ? b) quel est l’objectif poursuivi par l’entreprise ? c) comment les opérateurs sont-ils associés à la démarche ? d) quels sont les points de vigilance ?

2. La seconde catégorie de cas concerne des transformations organisationnelles

Ces transformations entraînent-elles ou non une plus grande autonomie et une participation plus active des opérateurs et des techniciens dans leurs activités quotidiennes de travail ? Constituent-elles aussi une opportunité de faire participer plus largement les personnels à la gestion du changement et à la définition des nouvelles conditions de travail (i.e. participation aux projets organisationnels ou technologiques) ?

Cette catégorie de cas vise à répondre aux questions suivantes : a) quelle est la vision qui préside à ces transformations ? quelle place pour l’humain ? b) quelles en sont (ou ont été) les principales étapes ? c) comment les personnels y ont-ils été associés ?

Enfin, le chapitre 4 tente d’évaluer comment les technologies et les nouvelles formes d’organisation du travail impactent positivement ou négativement l’autonomie des acteurs.

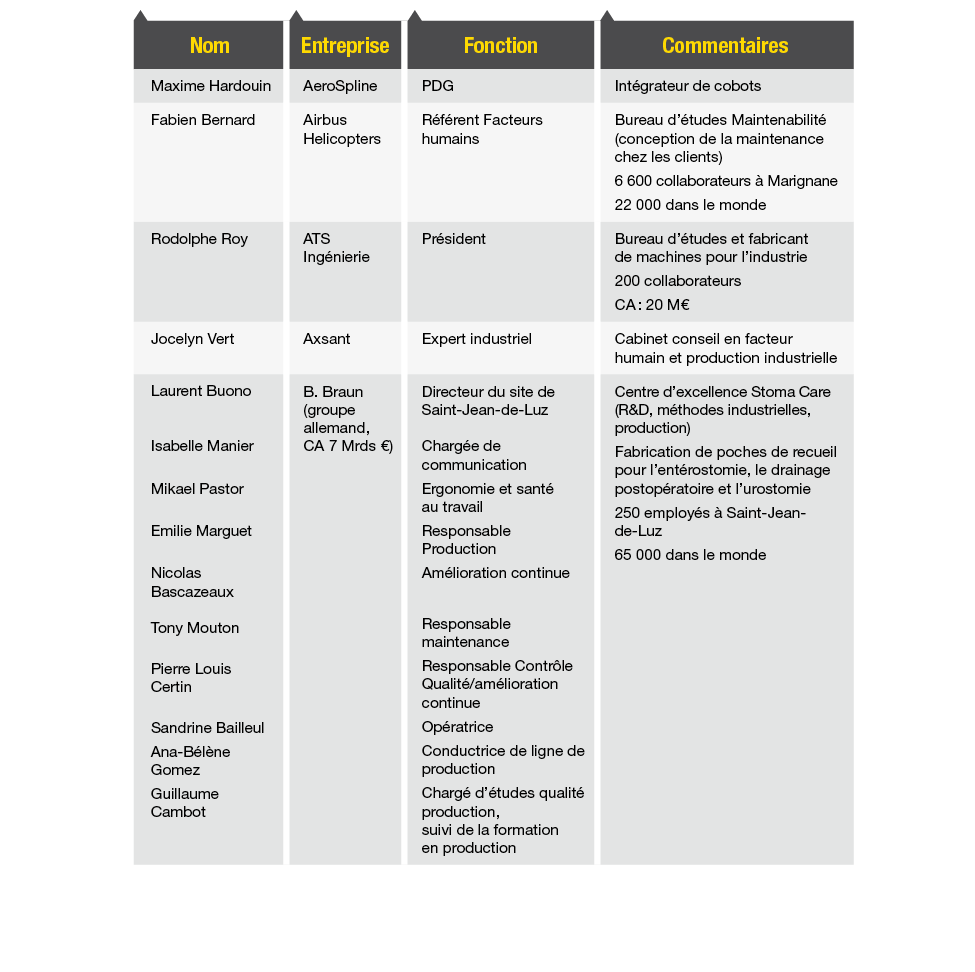

Méthode de l’étude

Pour documenter des situations relatives au design du travail dans les entreprises manufacturières, nous avons dans une première phase opéré une veille pour repérer des cas qui semblaient intéressants via la presse spécialisée, les blogs, le bouche-à-oreille, mais aussi via les labels « vitrine industrie du futur » décernés par l’Alliance Industrie du Futur (AIF).

Une série d’entretiens s’en est suivie par téléphone et/ou visioconférence (compte tenu du contexte sanitaire à l’époque de la recherche), avec un échantillon de dirigeants d’entreprise, responsables de production, de l’amélioration continue ou de transformation numérique, mais aussi avec des fournisseurs de solutions 4.0 et des bureaux d’études ou des cabinets de conseil chargés de les implémenter (voir Liste des personnes interviewées en annexe). Les personnes ont été informées du cadre de la recherche, dont le sujet et le contexte leur ont été brièvement présentés, et ont donné leur accord pour être enregistrées. Compte tenu de la crise sanitaire à l’époque de l’étude, seules trois visites sur site ont pu être conduites : chez Michelin à Roanne (antérieurement à la crise sanitaire), chez LYNRED à Grenoble, et chez B. Braun à Saint-Jean-de-Luz.

L’ensemble de ces comptes-rendus forment le matériau principal du présent rapport.

La méthode suivie pour cette recherche est celle de l’enquête narrative – aussi appelée recherche narrative ou analyse de récits13 – basée sur des récits formulés par des acteurs14. Elle a reposé sur un guide d’entretien servant d’aide-mémoire pour couvrir les principales questions de l’étude, mais les personnes interviewées sont restées libres de développer leur propre discours narratif, les questions permettant simplement de réorienter l’interlocuteur sur l’objet de la recherche s’il s’en éloignait trop ou d’approfondir les points évoqués en lien avec l’objet. En particulier, l’expression « design du travail », si elle a été brièvement introduite, n’a pas été précisément définie à chaque interlocuteur, permettant à chacun de s’en saisir assez librement selon sa compréhension. Ce dévoilement de l’interlocuteur à travers sa compréhension du sujet permettait en lui-même de saisir la place qu’il accordait à l’humain dans le cadre de son contexte et de son activité.

Les résultats de la recherche sont aussi exposés sur le mode du récit – reconstruit pour en dégager les points saillants –, de façon à ne pas s’éloigner artificiellement du matériau recueilli et à éviter d’y plaquer une grille de lecture a priori. Certains récits ont été regroupés quand ils exprimaient des processus récurrents ou des logiques d’action communes.

- 1. Les Notes de La Fabrique, Presses des Mines, 2019.

- 2. Marque déposée par la Fondation Mines ParisTech.

- 3. Guide : 10 questions sur la maîtrise des transformations numériques, ANACT, 2020.

- 4. Frederick Winslow Taylor, The Principles of Scientific Management, Harper & Brothers, 1911, dont la première traduction française date de 1912.

- 5. Voir, par exemple, les travaux de Benoît Meyronin, dont Manager l’expérience client-collaborateur : vers l’éthique du care, Dunod, 2020.

- 6. L’école des relations humaines, de Kurt Lewin, et plus récemment, les travaux d’Yves Clot.

- 7. E. Bourdu, M.-M. Péretié, M. Richer, La Qualité de vie au travail : un levier de compétitivité, Les Notes de La Fabrique, Presses des Mines, 2016, p. 69 ss.

- 8. Malgré de nombreuses études, les liens entre organisations responsabilisantes et performance des entreprises demeurent quan- titativement difficiles à établir. Voir, par exemple, Ibid., p. 69 ss ; Caillou P. et al., « Qualité de vie au travail et santé économique des entreprises : étude des causalités » in Bourdu, Lallement, Veltz et Weil, Le travail en mouvement, Presse des Mines, 2019, p. 5777 ; Benhamou S., Lorentz E., « Promouvoir les organisations du travail apprenantes : enjeux et défis pour la France », France Stratégie, avril 2020.

- 9. 2IES, «Autonomie, responsabilité, solidarité. Comment moderniser les relations professionnelles?», Les ozalids d’Humensis, 2020, chapitre 1.

- 10. Patricia Crifo, Antoine Rebériou, La Participation des salariés, Paris, Presses de Sciences Po, 2019.

- 11. Aslaug Johansen, Michel Sailly, Per Tengblad, Maarten Van Klaveren, Articulation entre la participation directe des travailleurs et les instances représentatives au sein des entreprises, à paraître.

- 12. Étude Insee Première n° 1844, mars 2021 https://www.insee.fr/fr/statistiques/5233929, citée in Jean-Marc Vittori, « Cette France qui compte plus de cadres que d’ouvriers », Les Échos, 23 mars 2021. https://www.lesechos.fr/idees-debats/editos-analyses/ cette-france-qui-compte-plus-de-cadres-que-douvriers-1300594

- 13. Voir Thierno Bah, Louis César Ndione, Alexandre Tiercelin, Les récits de vie en sciences de gestion , EMS, 2015.

- 14. « Analyse d’un récit par un acteur sur des événements qu’il a vécus. Le discours est provoqué par le chercheur. L’acteur reste libre de la formulation des faits et des interprétations qu’il en donne ». Voir Sanséau P.-Y., « Les récits de vie comme stratégie d’accès au réel en sciences de gestion : pertinence, positionnement et perspectives d’analyse », Recherches qualitatives , vol.25(2), 2005, pp. 33-57. Si cette méthode reste débattue en sciences de gestion, elle est au fondement de l’investigation de l’École de Paris du management depuis trente ans, à laquelle nous nous référons pour ce choix.

Le design du travail : une approche pragmatiste15

Le design du travail est une démarche éminemment pragmatiste – et pas seulement pragmatique. Quels enjeux pour le pragmatisme dans les organisations au xxie siècle ?

La philosophie pragmatiste est née comme une pensée critique qui nécessite de comprendre d’abord à quoi elle s’oppose : la philosophie idéaliste/rationaliste. Petite incursion philosophique.

Idéalisme, rationalisme, cognitivisme

Depuis Platon et Aristote, la représentation logique, l’enchaînement causal, fondent la connaissance. La représentation abstraite d’une chose est supérieure au jugement empirique porté sur cette chose, ce dernier pouvant aussi bien être une opinion vraie qu’une opinion fausse. Par exemple, je vois un bâton cassé à travers l’eau, mais je découvre qu’en réalité il s’agit d’un effet optique. Il convient donc de se méfier des jugements causés par nos sens et de s’affranchir des préjugés que produit l’expérience.

Descartes viendra prolonger ces lignes. Pour se débarrasser des préjugés issus de l’expérience humaine, le sujet doit se couper du monde pour exercer sa pensée fondée sur le doute et la raison, afin de produire des représentations logiques et, idéalement, mathématisables. Le dualisme est né, séparant pour plusieurs siècles la pensée et l’expérience, avec des conséquences assez bien connues sur le fonctionnement des organisations : l’intelligence de l’activité sera pensée à l’extérieur de l’activité, selon un programme rationnel.

Arrive là-dessus un penseur extraordinaire, Herbert Simon, chercheur sur les organisations mais aussi sur les systèmes d’information, qui vient en quelque sorte sauver le cartésianisme en l’aménageant. Pour Simon, face à la complexité, il est effectivement difficile de représenter la réalité par des modèles ex ante, mais il est, en revanche, possible de mettre en place des procédures de raisonnement ou des programmes procéduraux qui permettent de mutualiser et de traiter l’information au fur et à mesure où elle nous arrive. Simon parle de « computation », c’est-à-dire de la capacité pour une organisation, à la manière du cerveau, de traiter l’information par des processus logiques, basés sur des représentations communes et partagées. Le cognitivisme devient un nouveau paradigme, mais il ne rompt pas avec Descartes : l’action est toujours le produit nécessaire de représentations logiques.

La naissance des pragmatistes

En 1872, douze anciens diplômés de Harvard, férus de philosophie, se réunissent une dizaine de fois sous l’étiquette ironique de The Metaphysical Club : ironique, car ils n’ont en fait nullement l’intention de réfléchir à la métaphysique, mais plutôt de construire un nouveau courant philosophique opposé à celle-ci et adapté à leur temps : le pragmatisme. Les figures de cette philosophie américaine seront Charles Sanders Peirce, William James et, un peu plus tard, John Dewey.

Qu’est-ce qui caractérise leur temps ? Ils sortent tout juste de la guerre de Sécession, qui a tué un homme américain sur douze au nom de représentations du monde différentes ; les innovations technologiques se succèdent à grande vitesse, telles le chemin de fer, le téléphone de Bell, la lampe à incandescence d’Edison, le phonographe, la première caméra de prise de vue cinématographique ; la croissance est aussi faramineuse que l’immigration vers les États-Unis est massive. L’Origine des espèces de Darwin (1859) a permis de découvrir que l’évolution de la vie est un processus continu et mouvant, et que l’homme n’est pas une exception de la création mais fonctionne comme les autres espèces vivantes. Cet ouvrage sera l’une des sources du développement d’une conscience écologique aux États-Unis. Ce contexte général inspire les membres du Metaphysical Club dans leur tentative de se projeter vers le futur.

Selon les pragmatistes, il importe d’explorer tous les effets pratiques des théories. Quelle différence cela ferait-il en pratique si telle option plutôt que telle autre était vraie ? s’interrogent-ils. Les idées étant des instruments socialement construits (des croyances contingentes et relatives), il faut les mettre à l’épreuve à travers l’expérimentation sociale. La philosophie doit reproduire dans le domaine sociopolitique ce que la science moderne accomplit dans le domaine technologique. De cette philosophie complexe et débattue, retenons ce qui intéresse notre propos : le pragmatisme rejette le dualisme cartésien. Pour les pragmatistes, pensée et action sont inséparables : penser, c’est agir, et agir, c’est penser. Pour comprendre le réel, il faut tenter de le transformer. C’est en tentant de résoudre les problèmes qu’on en saisit les causes et les racines. Leur méthode ? Enquêter, expérimenter, explorer (voir encadré). Sur le plan philosophique, la réception du pragmatisme dans la France cartésienne sera globalement très critique (« une ploucquerie américaine »16).

L’enquête pragmatiste : du doute à la croyance17

L’enquête est le processus social par lequel des habitudes18 sont transformées, adaptées, abandonnées ou réinventées, à partir d’habitudes mises en échec qui aboutissent à des habitudes renouvelées.

L’enquête démarre sur un doute ou une indétermination. Elle se conclut par une nouvelle croyance19 qui est, par construction, temporaire. C’est une conviction en l’état des connaissances et dans un contexte donné. Cette nouvelle croyance implique alors de nouvelles habitudes, de nouvelles pratiques, de nouvelles manières de faire.

L’enquête articule différentes phases :

-

- Problématisation : que cherche-t-on à résoudre ? Cadrage de l’extension spatio-temporelle de l’enquête.

- Construction d’hypothèses (abduction) : quelles causes pourraient être à l’origine des faits observés ? La cause identifiée est considérée à ce stade comme la théorie

explicative la plus plausible. - Raisonnement logique (déduction) : quelles conséquences aurait l’hypothèse retenue ?

- Expérimentation : test de validité de l’hypothèse et de ses conséquences.

- Analyse du retour d’expérience pour valider de nouvelles hypothèses (raisonnement par induction)20.

Le processus n’est en fait pas linéaire. Les étapes de l’enquête sont inévitablement récursives et enchevêtrées.

Qui enquête ? Tous les acteurs concernés de manière significative par le thème d’une enquête devraient y prendre part, et, ensemble, construire le récit plausible de la situation et convenir de la suite à donner.

Les pragmatistes s’intéressent particulièrement aux effets qu’induit l’éducation sur le fonctionnement de la société. Dans son ouvrage Democracy and Education21, John Dewey consacre quelques pages à une critique de l’OST : « La tendance à réduire l’efficience de l’activité et le management scientifique à de purs facteurs techniques externes est la preuve que l’éducation de ceux qui contrôlent l’industrie n’a stimulé chez eux qu’un seul angle de pensée »22. Cette critique porte au-delà du taylorisme : elle s’attaque à toutes les approches de l’activité humaine qui sont conçues comme hétéronomes, c’est-à-dire où l’action est vue comme pure exécution (d’un plan, d’un programme) et où toute intelligence de l’action procède d’une pensée préalable qui lui est extérieure. Dans la conception hétéronome, l’intelligence de l’action est toujours amenée de l’extérieur (consultants, experts, managers, etc.). En revanche, dans la vision pragmatiste, l’intelligence de l’action est produite par ceux qui agissent. On peut prendre, comme exemple d’hétéronomie, la conception des programmes scolaires par l’Éducation nationale versus les pédagogies alternatives de type Montessori.

Applications du pragmatisme en gestion : management de la qualité et amélioration continue

Dans les années 1920, un jeune statisticien, Walter Shewhart, disciple des pragmatistes, est embauché à l’usine Hawthorne de Western Electric pour mettre au point un système préventif de contrôle de la qualité, qui deviendra la maîtrise statistique des procédés (1924). Il insiste sur deux aspects : a) le caractère exploratoire et expérimental de l’action ; b) l’idée que les outils ne peuvent être opératoires que s’ils sont mis au service des opérationnels de terrain.

Il embauche deux jeunes ingénieurs, William E. Deming et Joseph Juran, qui deviendront les pères du mouvement du management par la qualité. Sous l’influence de Deming, qui part travailler au Japon, Taiichi Ohno développera ensuite pour Toyota le Toyota Production System (TPS) qui se diffusera à travers le monde sous le nom de toyotisme ou lean manufacturing. Au fondement du système repose la maxime pragmatiste d’Ohno : « Les acteurs sont les penseurs de l’activité. »

La roue de Deming

Souvent mal compris, les principes de Shewhart, Deming et Ohno seront par la suite fréquemment dévoyés et « confisqués » par la domination de logiques cognitivistes, consistant à mesurer des écarts par rapport à des modèles rationnels conçus par des experts. Un bon exemple pour saisir ce dévoiement est le destin de la roue de Deming, connue sous le nom de PDCA (pour Plan, Do, Check, Act). En réalité, la boucle d’origine de Deming s’appelait PDSA (S pour Study) et reposait sur une logique expérimentale radicalement différente : la logique de l’enquête (voir figure 1.1).

Deming se battra jusqu’à sa disparition contre ce dévoiement du PDSA d’inspiration pragmatiste, consistant à le transformer en PDCA d’inspiration idéaliste/rationaliste.

Figure 1.1 – La roue de Deming : PDSA versus PDCA

Source : Adapté de P. Lorino (2020).

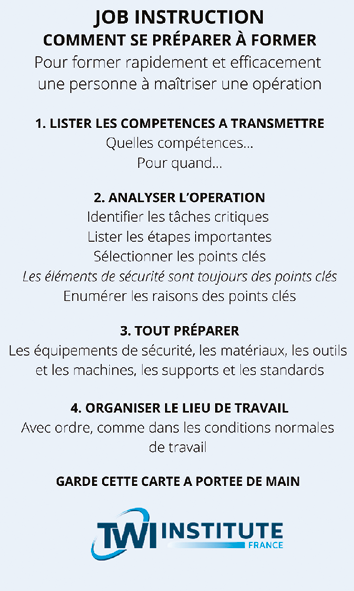

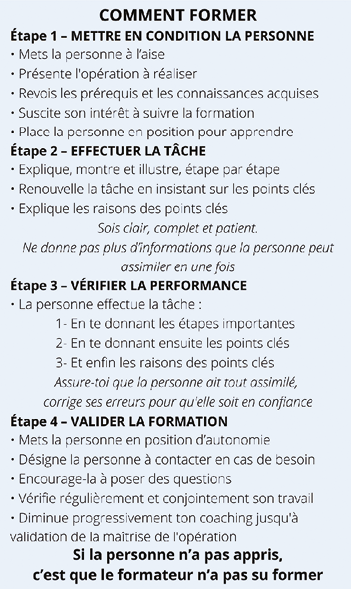

Le programme TWI

Le programme TWI (Training Within Industry) a été déployé pendant la Seconde Guerre mondiale aux États-Unis pour soutenir l’effort de guerre des industries d’armement. Il s’agissait de former massivement du personnel, alors que beaucoup de travailleurs étaient mobilisés et partaient au front. Outil de formation mais aussi de résolution de problèmes et de mise au point du standard, ce programme d’inspiration pragmatiste a fortement influencé l’industrie japonaise en reconstruction après la guerre, et en particulier Toyota. Un peu oublié en Occident, il fait l’objet d’un nouvel intérêt, car il entretient une parenté forte avec la formation en situation de travail (Afest)23.

Le TWI est une méthode de formation en situation de travail, qui prend racine dans les travaux de Charles Allen aux États-Unis dans son livre The Instructor, the Man and the Job (1919).

La méthode en quatre étapes d’Allen – Show, Tell, Do, Check – va connaître un succès retentissant dans les années 1940 : 1,7 million de managers et de formateurs dans 16 511 entreprises américaines vont apprendre à former au poste de travail, et 11 millions de personnes de « l’arsenal de la démocratie » vont apprendre à travailler. Le symbole en sera l’affiche de Rosie la riveteuse, une opératrice formée grâce au TWI, qui deviendra, des années plus tard, une icône des mouvements féministes.

Affiche We can do it!, dite Rosie la riveteuse

Créée par J. Howard Miller pour la Westinghouse Electric Company, 1942.

Au-delà d’une méthode de formation accélérée, le TWI permet de construire un langage commun sur les opérations et joue un rôle important dans la transmission des savoirs. On retrouve ici l’importance accordée à la formation-action par les pragmatistes, notamment par Dewey.

Le TWI a profondément influencé le système de production de Toyota pour les méthodes de mise au point du standard et de formation24. En revanche, sa diffusion en France est restée extrêmement limitée jusqu’à récemment. Parmi les raisons qui peuvent l’expliquer, il y a le fait que, dans cette méthode, le standard de production doit être mis au point avec les opérateurs. Il s’agit en effet d’un mode opératoire détaillé qui ne peut être réalisé qu’avec eux. La greffe a donc eu du mal à prendre dans notre système idéaliste/rationaliste de séparation pensée-action, qui donne l’exclusivité de la conception du travail aux méthodes.

À travers ces deux exemples, on voit combien le système de pensée appliqué peut transformer la nature même des outils considérés (roue de Deming) ou rendre difficile l’adoption d’une méthode (TWI). L’échec de nombreux projets d’implémentation du lean management, dans les années 1990 et 2000 en France, a certainement de nombreuses causes, mais il nous semble qu’elles prennent racine dans la difficulté de transposer un système de management d’inspiration pragmatiste dans une grille de lecture idéaliste/rationaliste.

Les enjeux du pragmatisme au xxi e siècle pour les organisations

En cette première moitié du xxie siècle, on peut identifier un renouveau du pragmatisme dans les organisations. Il existe, en effet, une continuité manifeste d’intention entre l’amélioration continue du Toyota Production System et la culture agile des start-up, toutes deux d’inspiration pragmatiste.

La culture digitale affiche une évidente parenté avec la philosophie pragmatiste :

• Se focaliser sur les approches expérimentales plutôt que sur la planification.

• Itérer en boucles de rétroaction rapides.

• Appuyer ses analyses sur des faits/données plutôt que se baser sur des opinions.

• Tester sans avoir peur d’échouer, l’échec d’une hypothèse contribuant à l’apprentissage (couramment désigné comme « droit à l’erreur » ou « test and learn »).

• Observer les usages pour créer de la valeur client.

• Autonomiser et responsabiliser plutôt que contrôler (subsidiarité plutôt que hiérarchie).

Figure 1.2 – New ways of working

Source : Adapté de la Digital Factory de Thales25.

Le paradigme que nous quittons est d’inspiration idéaliste/rationaliste, alors que le nouveau paradigme est d’inspiration pragmatiste.

La valeur attribuée à la nouvelle culture agile du digital26 (voir figure 1.2), désormais endossée et revendiquée par une immense majorité d’entreprises, pourrait laisser penser que, au moins sur le plan du discours, le pragmatisme a gagné du terrain dans la vie des organisations.

Cependant, au même moment, ce renouveau du pragmatisme entre en collision avec un renouveau du cognitivisme, symbolisé par les espoirs immenses placés dans le big data et l’intelligence artificielle. La valeur attribuée aux données, aux protocoles numériques et autres algorithmes de machine learning dans le paradigme du digital et de l’industrie 4.0, donne potentiellement aux modèles rationalistes et cognitivistes une puissance renforcée au sein des organisations. L’asservissement à la donnée – « c’est la donnée qui le dit » (donnée dont on ne sait souvent ni selon quelles hypothèses elle a été analysée ni quels en sont les biais possibles) – pourrait offrir encore moins de marge de manœuvre aux travailleurs que l’ancienne soumission à l’autorité – « c’est le chef qui le dit » (opinion et autorité que l’on peut toujours contester).

Le statut des données est donc assez ambigu. Dans les new ways of working du digital, les données sont présentées comme un élément de nature pragmatiste. Elles s’opposent aux opinions de nature idéaliste/ rationaliste. Plutôt que des opinions sur la meilleure façon de faire une campagne marketing par e-mail (mise en page, contenu, heure d’envoi…), les entreprises du numérique s’appuient sur des données statistiques obtenues par exemple à travers des campagnes en A/B testing pour valider quelle est la meilleure option. Le résultat n’est pas considéré comme une vérité intangible mais comme un résultat provisoire en l’état des hypothèses expérimentées. Il s’agit en quelque sorte d’une « enquête », et cette démarche est bien de nature pragmatiste. Mais la tendance à vouloir élargir ce management par la preuve à toutes les dimensions de l’entreprise présente un côté obscur. Si le résultat produit par le traitement des données ne fait l’objet d’aucune analyse ni de discussion critique, il s’opère alors un basculement vers un « nouveau cognitivisme » par la donnée. Les erreurs commises en 2015 par l’algorithme de reconnaissance d’images de Google, qui avait classé deux personnes noires dans la catégorie « gorille », et par Flickr qui en avait étiqueté une dans les catégories « animal » et « singe », montrent s’il en était besoin que la boîte noire des algorithmes peut produire des résultats aberrants. À côté des erreurs manifestes, on trouve aussi des biais, tels que ceux que mentionne Thierry Poibeau : « En 2018, Amazon abandonnait son système de tri automatique de CV après s’être rendu compte que le système rétrogradait systématiquement les CV féminins. Pourquoi un tel comportement ? Parce que les recrutements précédents, c’est-à-dire [les données à partir desquelles] avait été entraîné le système, étaient quasi exclusivement [constituées de profils] masculins : le système d’IA reproduisait les “biais” antérieurs »27. On voit donc que non seulement les données initiales servant au corpus d’entraînement ne sont pas « neutres » et peuvent être biaisées par des comportements passés, mais également que l’algorithme lui-même (souvent secret) peut venir renforcer les tendances principales contenues dans les données d’entraînement. « La possibilité de traiter des données plus abondantes au moyen d’algorithmes plus pointus renforce l’espoir que les situations peuvent être contrôlées rationnellement. Cependant, ce qui passe à travers les mailles du filet du traitement massif des données et des algorithmes sophistiqués est un concentré de nouveauté radicale, d’incertitude déroutante et de complexité chaotique »28, rappelle Philippe Lorino.

L’enjeu du pragmatisme pour les organisations est donc le suivant : voulons-nous avancer vers des modèles toujours plus rationnels et abstraits, et toujours plus de contrôle, ou vers un paradigme de l’action collective relationnelle, basée sur des approches participatives et de l’expérimentation ? Il n’est guère besoin de préciser dans quel camp se situe le design du travail, qui se place délibérément dans la filiation de Dewey, Deming et Ohno.

Cette oscillation entre pragmatisme et cognitivisme nous a paru souvent présente dans les situations rencontrées lors de cette étude, sans pour autant que nos interlocuteurs semblent en avoir une claire conscience. « La technologie n’est en soi ni bonne, ni mauvaise, ni neutre »29, nous dit Melvin Kranzberg. « Ni neutre » fait référence au fait que sa puissance impose de pouvoir s’appuyer sur un référentiel « politique », autrement dit sur la clarification, le partage et la mise en débat de l’intention qui est poursuivie par sa mise en œuvre. « Dans la perspective pragmatiste, il est essentiel que les sociétés préservent un équilibre entre le développement de moyens technologiques complexes et puissants et la capacité sociale de maintenir l’intelligibilité et la capacité d’action collectives, condition clé de la démocratie », dit encore Philippe Lorino. Transposé à l’échelle de l’entreprise, cela signifie laisser une place au pouvoir d’agir individuel et collectif et à la participation des travailleurs.

Face à l’accroissement du risque d’hétéronomie par la technologie, la participation des salariés et de leurs représentants à l’analyse et à la construction de leur propre travail, apparaît alors comme un garde-fou indispensable mais fragile.

Figure 1.3 – Idéalisme / cognitivisme versus pragmatisme30

Source : Créé par François Pellerin.

- 15. Cette section a trouvé sa source d’inspiration dans l’ouvrage fondamental de Philippe Lorino, Pragmatisme et étude des organisations , Economica, 2020, auquel nous renvoyons, ainsi que dans son intervention orale à l’ESG UQAM de Montréal, le 29 mars 2019. Nous avons étendu son exemple de la roue de Deming au cas du TWI, ainsi qu’aux new ways of working à l’âge du digital.

- 16. https://fr.wikipedia.org/wiki/Pragmatisme

- 17. Philippe Lorino, Pragmatisme et étude des organisations , Economica, 2020, chapitre 4.

- 18. Au sens de pratiques professionnelles communes.

- 19. Fait de croire qu’une chose est vraisemblable, possible.

- 20. Inférer la validité d’une théorie à partir d’un nombre limité d’expérimentations.

- 21. Dewey, John (1916). Democracy and Education: An Introduction to the Philosophy of Education. New York: Macmillan.

- 22. C’est nous qui traduisons : « The tendency to reduce such things as efficiency of activity and scientific management to purely technical externals is evidence of the one-sided stimulation of thought given to those in control of industry. »

- 23. L’Afest (action de formation en situation de travail), dont la pédagogie est articulée selon le constat que l’expérience de travail ne suffit pas à produire en ellemême des compétences susceptibles d’être réutilisées, mais qu’un temps réflexif accompagné par un formateur est nécessaire pour tirer les enseignements de ce qui s’est passé, analyser les écarts entre les attendus, les réalisations et les acquis, et ainsi consolider et expliciter les apprentissages (www.anact.fr).

- 24. Jeffrey K. Liker, David Meier, Toyota Talent: Developing Your People the Toyota Way (English Edition), McGraw-Hill Education, 2007.

- 25. https://nbry.wordpress.com/2019/04/08/accelerating-new-businesses-at-thales-digital-factory/

- 26. « Culture for a digital age », McKinsey Quarterly , 20 juillet 2017.

- 27. Thierry Poibeau, « Emploi, sécurité, justice : d’où viennent les “biais” des IA et peut-on les éviter ? », The Conversation, 4 février 2021.

- 28. Philippe Lorino, « Pourquoi une telle actualité du pragmatisme pour la recherche sur les organisations et pour les pratiques de gestion ? », 11 mars 2020. http://knowledge.essec.edu/fr/leadership/pragmatisme-organisation-management.html

- 29. Première loi de Melvin Kranzberg, professeur américain d’histoire des technologies. Kranzberg Melvin, « Technology and History: “Kranzberg’s Laws ” », Technology and Culture , 27 (3), July 1986, 544-560 .

- 30. https://philippesilberzahn.com/2011/02/28/comment-entrepreneurs-pensent-agissent-principes-effectuation/

Outils technologiques et implication des opérateurs

La première catégorie de situations examinées dans cette étude concerne l’introduction ou le déploiement d’outils technologiques relevant plus ou moins de l’industrie 4.0. Ces situations permettent de comprendre : a) ce que ces outils changent dans la façon d’effectuer le travail ; b) la manière dont les techniciens et les opérateurs de production sont associés à ces déploiements.

Ces cas sont centrés sur quelques catégories d’outils et de dispositifs numériques parmi les plus emblématiques de l’industrie 4.0.

Les technologies de conception viennent faciliter la conception des opérations ou des moyens de production et sont généralement pilotées par les bureaux d’ingénierie ou les méthodes avec le concours d’ergonomes, à partir de l’observation du travail des opérateurs. Ces nouveaux outils de simulation ou d’immersion virtuelle permettent une analyse du facteur humain, essentiellement du point de vue de la santé et la sécurité au travail, afin de l’intégrer à la conception du produit (facilitation à le monter, à le dépanner) ou à la conception des moyens de production (création d’une nouvelle usine, analyse des flux, implantation des machines dans l’usine, etc.).

Les technologies d’assistance avec lesquelles l’opérateur interagit sur la ligne ou l’îlot de production, de manière à accélérer, améliorer ou faciliter les opérations ou les décisions liées aux opérations (outils d’aide à la décision à base d’IA, montres, tablettes ou autres objets connectés, cobots et autres automatismes).

Ces deux grandes catégories n’épuisent pas le sujet : d’autres technologies telles que les technologies de communication ou de collaboration (agendas partagés et plateformes de partage, environnements numériques de travail pour le travail au bureau ou le travail à distance, réseaux sociaux d’entreprise), les technologies de gestion et de pilotage de l’activité (ERP, MES) ou les technologies de formation (e-learning, réalité virtuelle ou augmentée appliquée à la formation) auraient également pu être évoquées, mais elles ne l’ont pas été par nos interlocuteurs.

Les responsables interrogés manifestent clairement le souci et la volonté d’intégrer le facteur humain dans la conception de ces outils de travail. Mais ce qui distingue souvent les approches, c’est le niveau de considération accordé aux opérateurs et leur niveau de participation à la définition de leurs propres besoins.

Très schématiquement, on peut distinguer ces approches selon qu’elles posent le travailleur comme objet ou comme sujet : a) objet d’observation et d’étude pour concevoir ensuite les outils et méthodes de travail de façon hétéronome ; b) sujet participant et agissant à la coconstruction de son activité et des outils de son travail ;… et toutes sortes de nuances ou de gradations entre ces deux extrêmes.

Ou, pour le dire autrement, on peut distinguer les approches pour le travailleur ou avec le travailleur.

Intégrer le facteur humain dans les modélisations numériques de conception

Chez Airbus Helicopters, de nouvelles chaînes automatisées d’assemblage sont en préparation pour un nouveau modèle d’hélicoptère, le H160. Les personnes du bureau d’études travaillent sur des maquettes numériques pour concevoir ces nouvelles chaînes et y intégrer le facteur humain (voir encadré).

Facteurs humains et ergonomie

Les facteurs humains et l’ergonomie sont l’application de principes psychologiques et physiologiques à l’ingénierie et à la conception de produits, de processus et de systèmes. Le but des facteurs humains est d’atteindre des objectifs de santé et sécurité au travail, de réduire l’erreur humaine, d’augmenter la productivité et d’améliorer le confort, en mettant un accent particulier sur l’interaction entre l’humain et l’objet d’intérêt.

Il existe deux grands courants qui caractérisent l’ergonomie : le courant human factors à prédominance anglo-saxonne et l’ergonomie de l’activité, appelée jusqu’à récemment ergonomie de langue française.

L’approche human factors assure une adaptation des outils aux caractéristiques des personnes (en lien avec l’anatomie, la physiologie et la psychologie) indépendamment du contexte, alors que l’ergonomie de l’activité, plus intégrative et systémique, assure l’adaptation des outils aux personnes et aux exigences des contextes, en se focalisant sur les situations de travail réel et l’environnement de travail.

Pendant longtemps, un hélicoptère était assemblé en poste fixe. Les nouvelles chaînes de montage, en revanche, sont « avançantes » – comme dans l’automobile –, ce qui est assez nouveau dans l’aéronautique et permettra une montée en cadence de la production. Pour prendre en compte et intégrer le facteur humain dans ces nouvelles chaînes, les ingénieurs ont mis en place une méthode, appelée le ring numérique, qui vise, autour de CATIA31, à placer un mannequin numérique dans un environnement virtuel qui simule les flux de la future chaîne (avec le logiciel DELMIA32). Ils déplacent alors le mannequin entre un point A et un point B, et lui font réaliser différentes tâches. La préparation amont de la simulation est faite par des spécialistes en mécanique et en design. Ensuite, intervient une « revue collaborative » de tous les métiers qui seront impliqués sur la future ligne : un groupe de travail se réunit comprenant les ingénieurs concernés par le développement, un ergonome et un opérateur qui connaît bien l’environnement. Les concepteurs projettent la simulation et les personnes discutent entre elles de la faisabilité de la tâche considérée. Cette méthode n’était jusqu’ici pas habituelle en aéronautique et représente une innovation organisationnelle.

Pour que cette approche développe tout son potentiel, il faut s’assurer que le groupe de travail reste au complet, depuis la préparation jusqu’au déroulement de la « revue collaborative ». Il est apparu notamment que, sans ergonome dans la phase de préparation de la simulation, certains paramètres ne sont pas pris en compte. Par exemple, un ergonome proposerait de prendre plusieurs mannequins numériques de différentes tailles pour effectuer une même tâche, dans plusieurs types de postures et en interaction avec l’environnement33. De même, lors de la revue collaborative, il peut parfois manquer soit l’ergonome, soit l’opérateur, soit les deux. Et lorsqu’ils sont absents, de nombreuses questions et remarques qui auraient pu être pertinentes passent à la trappe. En revanche, quand l’opérateur et l’ergonome participent, l’analyse est beaucoup plus fouillée : le groupe peut passer une demi-heure sur une tâche que les équipes de conception auraient expédiée en cinq minutes.

Lorsque le groupe identifie un gros problème sur la maquette numérique, un ring physique peut avoir lieu, c’est-à-dire que la scène est rejouée « pour de vrai » par un opérateur dans une maquette physique, afin de déceler ce qui n’a pas pu l’être en numérique. Que ce soit en numérique ou en physique, l’idée sous-jacente est bien de faire des itérations pour améliorer l’ergonomie. Quand l’ergonome et l’opérateur sont absents, il est plus facile pour les autres de tout valider en une seule session et de ne plus y revenir. Ainsi, au vu de l’impact positif du ring numérique et physique, une voie de progrès générale consisterait à intégrer à tout projet de conception l’ergonome et les opérateurs le plus en amont possible, et à s’assurer de leur participation à toutes les étapes du processus.

Fabien Bernard a produit une thèse en ergonomie34 dans un autre service d’Airbus Helicopters (la Maintenabilité), en charge des aspects de conception qui affecteront la maintenance des hélicoptères chez les clients – maintenance réalisée par des opérateurs qui généralement ne font pas partie d’Airbus. Si au bureau d’études Production, on s’occupe de savoir comment l’hélicoptère sera monté, à la Maintenabilité, on se préoccupe de comprendre comment il sera démonté. Fabien Bernard a étudié les apports de différents outils de simulation – maquette numérique, mannequin numérique, réalité virtuelle, maquette physique –, avec les mêmes tâches de maintenance, permettant ainsi l’étude du facteur humain au moment de la conception, afin de mesurer les écarts éventuels entre la réalité physique et la réalité virtuelle. Il a utilisé pour cela, au-delà de la maquette physique parfaitement représentative de la réalité, une plateforme de réalité virtuelle dans laquelle ont été ajoutés des objets physiques. Le sujet est immergé dans la plateforme virtuelle ; à l’intérieur de son casque il voit ses mains en avatar, qui lui serviront, par exemple, à réparer un alternateur virtuel, mais la particularité, c’est qu’on a ajouté physiquement dans l’environnement un véritable alternateur qui pèse 20 kilos. L’étude a ainsi pu établir que les écarts entre la réalité virtuelle avec ajout d’éléments physiques (ou réalité virtuelle tangible) et une maquette physique étaient peu significatifs pour ce qui concerne les aspects physiques de l’activité. Certains critères des aspects cognitifs et organisationnels du travail sont également quantifiables. Sa recherche légitime donc la possibilité d’étudier le facteur humain en environnement virtuel à la condition que soit pris en compte l’ensemble des facteurs ergonomiques.

Pour son étude, Fabien Bernard a systématiquement fait participer aux simulations en réalité virtuelle de vrais opérateurs de maintenance, et non des personnes du bureau d’études. Cela a deux vertus selon lui : la première, c’est qu’ils connaissent le terrain et ont donc une vision beaucoup plus réaliste des gestes, des postures et de l’organisation de l’espace que celle d’une personne issue du bureau d’études ; la seconde est que les vrais opérateurs peuvent aussi remplir un questionnaire permettant de jauger leur charge mentale35 tout en exposant leur propre vécu, leur expérience du terrain chez Airbus ou chez les clients. Ces observations ont permis de construire des indicateurs ergonomiques aujourd’hui pris en compte par les concepteurs travaillant sur la maintenance future des hélicoptères (par exemple, la position et le dimensionnement d’une trappe). Des protocoles ergonomiques sont également intégrés aux maquettes numériques (par exemple, les mannequins de différentes tailles). Cette approche adaptée aux non-spécialistes en ergonomie ne se substitue pas à l’ergonome mais permet à chaque acteur métier du bureau d’études de se poser les bonnes questions, de réaliser en autonomie des analyses préliminaires avant de se rapprocher de l’ergonome, si nécessaire. Les rapports issus des simulations sont ainsi beaucoup plus fournis, homogènes en matière d’ergonomie et permettent de chercher des compromis avec les autres départements pour obtenir des architectures d’hélicoptères et des outillages qui soient plus adaptées aux activités humaines de maintenance.

Dominique Soler est président-fondateur de Human Design Group (HDG), une société en pointe qui accompagne les ingénieries des grands groupes pour intégrer les facteurs humains dans le design de systèmes hommes-machines (conception d’une usine, d’une salle de contrôle de centrale nucléaire, d’un cockpit d’avion, etc.), en maîtrisant, le plus tôt possible, les variables socio-organisationnelles et humaines significatives pour l’efficience visée du système (diminution des coûts de formation, du risque d’erreur, etc.). Dans ce cadre, il développe et utilise, entre autres moyens de simulation, des briques de réalité virtuelle et constate que la simulation centrée sur l’homme arrive encore beaucoup trop tard dans le cycle de conception des systèmes hommes-machines a fortiori complexes. Pourtant, assure Dominique Soler, « la convergence actuelle et la maturité des technologies de réalité virtuelle et de neuroergonomie ouvrent la voie à l’utilisation plus en amont de nouveaux moyens de simulation moins coûteux que les simulateurs habituels, en offrant un bon niveau de représentation et de mise en situation des opérateurs, adapté à l’accélération des processus de design en général et de ceux centrés sur l’homme en particulier ». La finalité est d’immerger l’utilisateur dans un ensemble de situations représentatives qui vont permettre d’éprouver la performance des interactions socio-organisationnelles et humaines avec les artefacts technologiques et ainsi d’améliorer la performance d’usage et la résilience de fonctionnement du système à concevoir. Pour concevoir la future situation de travail ou adapter une situation existante, il y a trois étapes : a) la compréhension et la modélisation des variables de la situation de travail, nécessaires à sa simulation ; b) le design de la solution permettant de répondre avec efficience aux exigences de fonctionnement des variables de la situation de travail (interactions digitales, environnement physique et organisationnel du travail) ; c) la mesure de la performance des usages de la situation de travail recréée, grâce à la mise en œuvre de méthodes de mesures principalement issues de la psychologie cognitive et, dorénavant, de capteurs centrés sur l’état psychophysiologique des opérateurs (notamment dans le cadre de la pénibilité physique mais aussi de la charge cognitive, du stress ou de l’endormissement…).

« Un utilisateur, c’est comme un millepattes Il sait faire des choses formidables, mais il est incapable de vous expliquer comment il les fait , la plupart de ses habiletés et savoirfaire étant automatisés , donc difficiles à verbaliser. » Il est, par conséquent, nécessaire de recourir à des moyens de mise en situation recréée capables de révéler les réalités du travail et les conditions réelles de son efficience. La réalisation de plateformes de réalité virtuelle centrées sur l’observation et la capture de variables socio-organisationnelles et humaines permet d’observer l’opérateur et de capter l’information qu’il produit en situation d’activité, afin de concevoir, de la façon la plus efficiente possible, la situation d’activité future.

En résumé

Outils : outils numériques de simulation et réalité virtuelle en conception.

Objectifs de l’entreprise

• Prendre en compte par anticipation la santé et la sécurité au travail en conception de produits ou de moyens de production.

• Favoriser la résilience de systèmes complexes par la prise en compte du facteur humain (erreurs et accidents).

Modalités d’association des opérateurs

• Objet d’observation et d’étude (immersion virtuelle, utilisation de capteurs ou de questionnaires).

• Participation ponctuelle à la « revue collaborative » de conception.

Points de vigilance

• Associer de « vrais » opérateurs aux simulations.

• Tester l’ensemble des paramètres ergonomiques (et pas seulement les aspects biomécaniques).

• Faire intervenir les paramètres humains suffisamment en amont du processus de conception.

• Ne pas se fier au tout-numérique (oublier de voir, de toucher, de dialoguer).

Adapter les machines aux hommes

Rodolphe Roy dirige ATS, une entreprise familiale d’ingénierie industrielle de 200 salariés, qui étudie, calcule et conçoit des moyens de production au service de grands donneurs d’ordres et d’ETI de toutes les filières industrielles.

« Faire grandir les usines qui font grandir les Hommes », telle est la raison d’être36 que s’est choisie récemment ATS, et cela a conduit l’entreprise à travailler différemment. Quand un client apporte un cahier des charges technique pour la conception d’une machine, ATS déclare désormais que cela ne lui suffit plus ; il lui faut en plus un cahier des charges « sensoriel », c’est-à-dire intégrant les spécificités des utilisateurs finaux. Auparavant, les clients emmenaient souvent des opérateurs chez ATS, en phase de réception, pour tester la machine ou l’outillage, mais c’était trop tard, la machine était finie et les adaptations ne pouvaient être que marginales. Désormais, il s’agit d’intégrer les besoins des utilisateurs finaux dès la conception des outils de production : « Vous savez, les cols-bleus de l’atelier qui subissent les moyens de production qu’on leur amène sans que jamais on ne leur ait demandé quel était leur problème. »

Il y a quelques années, ATS doit livrer plusieurs machines au groupe Schneider : en Europe, en Chine et au Mexique. Une fois le prototype validé, le chef de projet de Schneider demande à l’entreprise de dupliquer la machine pour tous les pays : « Si on avait bien fait notre travail à l’ époque, on se serait rendu compte, avant de livrer la machine au Mexique, qu ’elle était trop haute parce que l’opérateur mexicain est en moyenne plus petit que l’opérateur polonais. »

Autre exemple : pour un groupe automobile, ATS livre une machine d’assemblage de climatiseurs à Mulhouse dans une très grande halle. La machine fait certes un peu de bruit parce qu’elle contient des moteurs et des vérins, mais elle est parfaitement conforme aux normes CE et, dans cette grande usine, personne n’est particulièrement incommodé. La machine est alors dupliquée pour un site du même groupe au Portugal. Et là, surprise ! La machine est placée au troisième étage d’un bâtiment de bureaux réaménagé en atelier. Avec 2,5 mètres de hauteur sous plafond et des murs aussi fins que ceux d’un immeuble d’habitation, le bruit devient totalement insupportable : « Si on avait été voir ou écouter les opérateurs, on aurait su que ce n’était pas possible, mais on n’a écouté que le chef de projet du client. »

Désormais, changement de braquet : les chefs de projets ATS vont voir les lieux et les personnes. Et si l’usine est trop éloignée, place aux outils digitaux ! Les clients reçoivent un casque de réalité virtuelle connecté à la plateforme numérique de conception pour impliquer l’opérateur dès les premières phases et résoudre les problèmes d’ergonomie. Récemment, ATS a conçu un nouvel outillage de soudage pour assembler des moissonneuses-batteuses de John Deere, le grand constructeur de matériel agricole. La maquette numérique 2D est envoyée au bureau d’études du client, et un opérateur-soudeur tente de vérifier s’il peut accéder à tous les points de soudure prévus sans trop se faire mal. Mais le client n’est pas convaincu. ATS envoie alors au bureau d’études un casque de réalité virtuelle qui fait apparaître le modèle 3D à échelle 1 et un gant qui permet de simuler la torche de soudage. Le soudeur vérifie alors tous les accès, le modèle est validé en quelques minutes et le bon de commande est passé dans la foulée.

Le moment où cette réalité virtuelle intervient (en amont ou en aval du processus de conception des machines) est important et peut révéler des philosophies différentes. En tant que donneur d’ordres, Hutchinson l’utilise, par exemple, au moment de la réception de machines ou d’outillages fabriqués en Chine. Comme l’entreprise ne va pas déplacer son personnel en Chine, elle fait participer à cette phase de test le CHSCT37 et les opérateurs par réalité virtuelle. Cela permet d’ultimes aménagements mais ne renverse pas le processus de conception de la machine.

Pour des projets plus complexes (implantation de plusieurs machines ou de lignes complètes), l’environnement d’implantation est désormais souvent numérisé en amont, ce qui permet de « placer » le matériel neuf dans les différentes zones de l’usine. Les opérateurs reconnaissent leur environnement et peuvent dire (si on le leur demande) : « Là, le chariot élévateur, il ne passera plus. » De nombreuses situations peuvent ainsi être anticipées et gérées. Rodolphe Roy souligne que cela a aussi changé le travail de ses propres collaborateurs, qui apprécient de parler de technicien à opérateur. Et de conclure : « Cette transformation digitale, elle ne pourra être réussie que si elle fait grandir les humains dans les usines. Si c’est juste pour amener de la performance digitale, amener de la data et aller un peu plus vite, on aura loupé quelque chose et ça se passera mal. Ce ne sera pas accepté dans les usines. »

Côté clients, impliquer les personnels dans l’adaptation de l’outil de production commence à devenir assez fréquent. Chez B. Braun, fabricant de dispositifs médicaux à Saint-Jean-de-Luz et filiale d’un grand groupe familial allemand, Sandrine Bailleul, opératrice, témoigne : « Mon ancien chef d’atelier est venu me voir pour me proposer d’être sur le projet de la LFP9. Nous sommes partis découvrir la nouvelle machine en Allemagne avec un technicien et une autre opératrice. On a pu formuler des demandes d’adaptation. Par exemple, il y avait un système de sécurité avec une clé qui était trop haute, un marchepied qui gênait et qui a été retiré. L’idée d’envoyer les gens à l’extérieur pour voir la machine et de pouvoir dire ce qu’on en pense, ce qu’on peut améliorer, c’est vraiment génial. »

Ces démarches devraient encore s’étendre dans les prochaines années parce qu’elles découlent des obligations de la nouvelle norme ISO 45001 pour un système de management de la santé et sécurité au travail (S&ST). Cette norme, qui a abouti en 2018 après une genèse laborieuse, a été adoptée par de nombreux organismes nationaux de normalisation en remplacement de la norme 18001. L’ISO 45001 pose le principe d’intégrer les élus du personnel et les personnels non encadrants dans les choix pouvant impacter la sécurité et la santé au travail, dont le choix des machines, les modifications des situations de travail, etc.

ISO 4500138

L’ISO 45001 s’appuie sur l’OHSAS 18001 – référence antérieure en matière de santé et sécurité au travail (S&ST). Il s’agit d’une norme distincte nouvelle, et non d’une révision ou d’une actualisation de l’ancienne, qui devrait être progressivement introduite dans les années qui viennent. Le principal changement est que l’ISO 45001 se concentre sur l’interaction entre un organisme et son environnement métier, tandis que le référentiel OHSAS 18001 était axé sur le management des dangers en matière de S&ST et d’autres problèmes internes. Mais les normes diffèrent également à de nombreux autres égards : ISO 45001 répond à une approche processus, alors que le référentiel OHSAS 18001 établit une procédure ; elle tient compte des risques et des opportunités, là où 18001 ne traitait que des risques ; et surtout, elle intègre le point de vue des parties intéressées, ce que ne faisait pas la norme précédente.

Extrait39 : 5.4 Consultation et participation des travailleurs

« L’organisme doit établir, mettre en œuvre et tenir à jour un (des) processus pour la consultation et la participation des travailleurs et, quand ils existent, des représentants des travailleurs, à tous les niveaux et pour toutes les fonctions applicables, dans le développement, la planification, la mise en œuvre, l’évaluation des performances et les actions d’amélioration du système de management de la S&ST. […]

d) mettre l’accent sur la consultation des travailleurs non encadrants sur ce qui suit : […]

Suit une liste de thématiques sur lesquelles les travailleurs non encadrants ou leurs représentants doivent être consultés ou doivent participer. [C’est nous qui soulignons]

En résumé

Outils : outils numériques de simulation et réalité virtuelle (RV).

Objectifs de l’entreprise

• Adapter la conception des machines et des outillages aux aspects ergonomiques de l’activité.

• Respecter la nouvelle norme de santé et sécurité au travail.

Modalités d’association des opérateurs

• Recueil des besoins via un cahier des charges « sensoriel » et itératif (côté four-

nisseurs).

• Participation aux demandes d’adaptation en phase de réception des machines.

Point de vigilance

• Moment d’utilisation de la RV : en phase de conception ou en phase de réception ?

L’IA qui assiste les opérateurs

Que ne lit-on pas sur l’intelligence artificielle et sur son impact maléfique sur le travail des hommes. Attention danger, l’IA risque de bientôt tous nous remplacer !

Michel Morvan est un mathématicien, spécialiste de la modélisation des systèmes complexes, président de l’Institut de recherche technologique SystemX et membre du réseau d’experts en intelligence artificielle de l’OCDE. Il dirige aussi Cosmo Tech, une start-up qui déploie des logiciels de simulation de systèmes complexes (réacteurs nucléaires, par exemple) pour optimiser les actifs industriels. Pour lui, il existe un grand malentendu sur ce que recouvre exactement l’intelligence artificielle : « En l’état actuel des choses, l’intelligence artificielle ne fait pour l’essentiel que mimer l’une des deux grandes fonctions du cerveau, en l’occurrence la reconnaissance. L’autre faculté de l’intelligence humaine, à savoir la compréhension, lui est encore étrangère. […] Toutes les applications dont on parle aujourd’hui ne consistent en rien d’autre que cela. Si l’intelligence artificielle présente un avantage par rapport au cerveau humain, c’est qu’elle permet de reconnaître non seulement plus rapidement mais encore à une plus grande échelle. Elle détecte bien mieux toutes sortes de phénomènes : des risques de panne, des tumeurs,… Plus généralement, aucune application basée sur l’intelligence artificielle n’est en mesure de “comprendre” ce qu’elle reconnaît. […] C’est pourquoi nous préférons parler d’“intelligence augmentée”, plutôt qu’artificielle »40.

Intelligence augmentée

C’est cette intelligence augmentée dont Éric Perrin, ancien technicien de maintenance devenu responsable de l’amélioration continue, a fait l’expérience sur le site français du papetier norvégien Norske Skog (325 salariés) qui produit en continu des rouleaux de papier journal. En 2006, Éric Perrin a un problème récurrent de rupture du papier sur une des deux machines du processus de production. Déjà à cette époque, il décide de faire analyser les données collectées sur la machine par un logiciel de data intelligence, conçu par la société Braincube. Une fois les données corrélées et traitées, le logiciel émet des recommandations pour de nouvelles règles de fonctionnement de la machine, c’est-à-dire un ensemble de fourchettes de paramètres pour obtenir un meilleur résultat. S’ensuit une discussion critique au sein de l’usine pour valider cette nouvelle règle et pour que tout le monde s’engage à l’appliquer. Résultat : 70 % de casse papier en moins sur la machine. Par la suite, l’ensemble des processus de l’usine seront connectés sous Braincube, qui analyse des milliers de paramètres.

« Le logiciel ne fournit aucune explication sur les jeux de paramètres qu’il propose. C’est en travaillant ensuite en équipe qu’on en trouve parfois les raisons. Mais il y a plein de trucs qu’on ne comprend toujours pas. » Ainsi, par exemple, une des règles déterminées par le logiciel postulait que le niveau de la pâte à papier dans les silos où elle est stockée avant le prélèvement pour passage en machine, avait un impact sur la rupture papier, et qu’il fallait le maintenir bas. Mais un bas niveau dans les silos, c’est un risque de rupture du flux, donc d’arrêt machines. Les responsables de la pâte contestaient donc la règle. Celle-ci a cependant été testée et cela améliorait clairement le processus. Ce n’est que bien plus tard qu’un thésard accueilli dans l’entreprise a apporté l’explication : la pâte stockée dans les silos vieillit ; donc plus le niveau est élevé, plus les couches supérieures de pâte, stockées plus longtemps, vieillissent, occasionnant un phénomène de précipitation chimique qui provoque des points collants, lesquels se déposent ensuite dans la machine. Comme le montre cette histoire et comme le dit Michel Morvan, « les seules “machines” à même d’apprendre par elles-mêmes à raisonner sont les êtres vivants »41.

Éric Perrin souligne également que l’accès aux données entretient des rapports étroits avec l’autonomie en matière de résolution de problèmes, dès lors que ces pratiques ont été développées préalablement (voir chapitre 3). Les écarts par rapport à la règle génèrent des alertes et les opérateurs commencent immédiatement à faire de la résolution de premier niveau : qu’est-ce qui se passe ? est-ce que je peux corriger ? Les opérateurs ne sont pas tenus d’obtenir un résultat mais doivent mettre en œuvre les actions correctives et appeler les services supports seulement s’ils n’y arrivent pas. Selon Éric Perrin, 80 % des problèmes sont ainsi résolus au niveau des équipes de production.

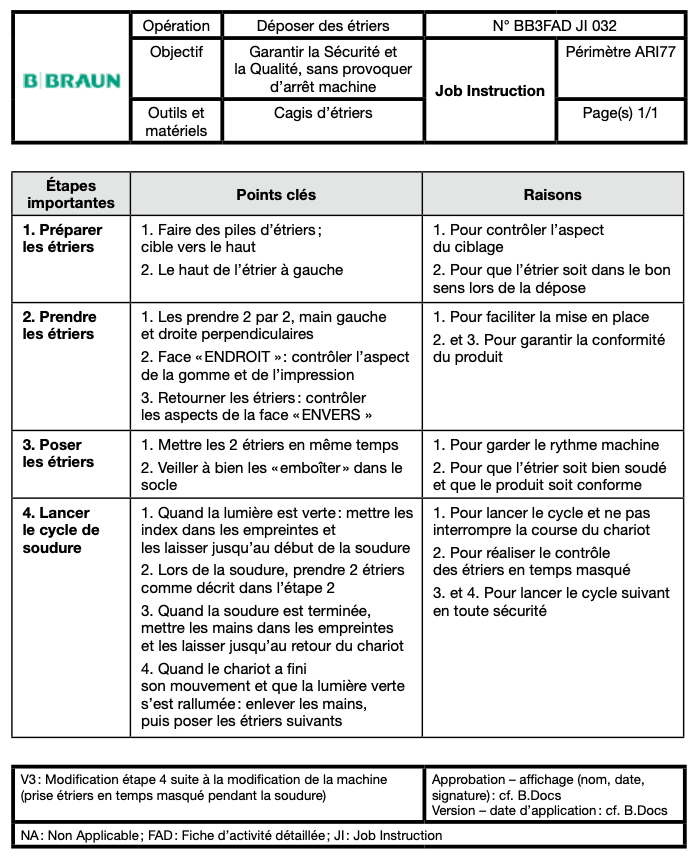

Ouvrir la boîte noire de l’IA